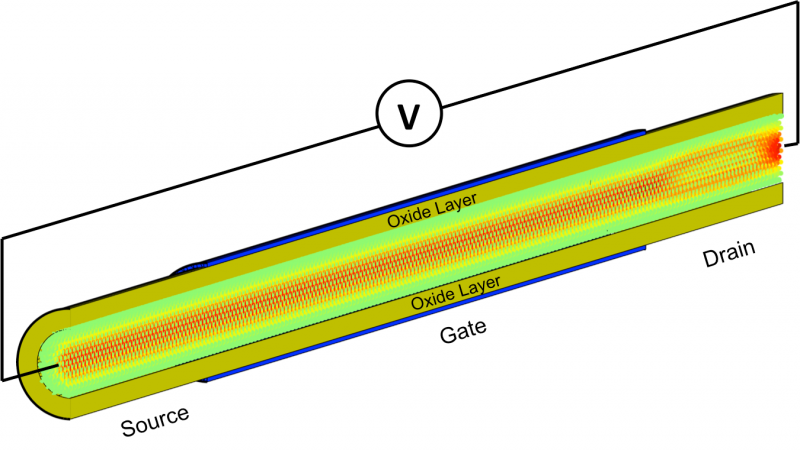

Distribuição espacial da corrente de elétrons fluindo através de um transistor de efeito de campo de nanofio de porta de silício completo composto por 55, 488 átomos. Uma tensão (V) é aplicada à estrutura. Metade da camada de cobertura de óxido é removida para lançar luz no interior do transistor, onde os átomos são coloridos de acordo com a corrente que carregam:verde significa sem corrente, enquanto o vermelho indica uma alta concentração.

Os pesquisadores da ETH Zurich estão usando o supercomputador mais rápido da América para obter grandes ganhos na compreensão dos menores dispositivos eletrônicos.

O time, liderado por Mathieu Luisier, concentra-se em desenvolver ainda mais a linha de frente da pesquisa eletrônica - simulando e melhor compreendendo componentes em nanoescala, como transistores ou eletrodos de bateria, cujas regiões ativas podem ser da ordem de um bilionésimo de metro, ou enquanto suas unhas crescerem em um segundo.

Embora as escalas dos objetos investigados sejam pequenas, a equipe fez um grande progresso em direção a códigos computacionais mais eficientes. Sua pesquisa foi selecionada como finalista do Prêmio Gordon Bell da Association of Computing Machinery deste ano, um dos mais prestigiosos prêmios em supercomputação.

A entrega do prêmio da equipe é resultado de uma pesquisa conduzida no supercomputador Cray XK7 Titan da Oak Ridge Leadership Computing Facility. O OLCF é uma instalação do usuário do Office of Science do Departamento de Energia dos EUA, localizada no Laboratório Nacional de Oak Ridge.

Laptops, telefones celulares e outros dispositivos eletrônicos estão se tornando mais baratos e acessíveis, ao mesmo tempo que se tornam cada vez mais sofisticados. Esses avanços são em grande parte devido às dimensões cada vez menores de seus componentes eletrônicos.

Contudo, desenvolver hardware de última geração agora requer cientistas e engenheiros para entender as interações de materiais em escalas de tempo e tamanho extremamente pequenas, levando pesquisadores a aumentar o experimento com simulação.

"Nosso objetivo é estudar dispositivos em nanoescala, como nanotransistores, baterias ou uma variedade de outros novos dispositivos, como memórias de computador, interruptores ópticos ou diodos emissores de luz em nível atômico, "Luisier disse." Se você quiser fazer essas simulações precisas e verdadeiramente preditivas, você precisa usar o chamado ab initio, ou dos primeiros princípios, métodos de simulação. "

Essencialmente, As simulações ab initio permitem que os pesquisadores modelem qualquer sistema atômico do zero, sem a necessidade de parâmetros de material pré-calibrados. Claro, alcançar esse nível de precisão não é gratuito. O preço é um aumento de mil vezes na complexidade computacional em comparação com, por exemplo, abordagens semi-empíricas que usam entradas de experimentos para simplificar o cálculo.

Os pesquisadores que estudam nanoeletrônica, portanto, normalmente têm que fazer um compromisso entre simular um tamanho de sistema realista (pelo menos 10, 000 átomos) e usando métodos ab initio altamente precisos.

Até este ponto, no entanto, a maioria dos pacotes de software ab initio se concentra no cálculo de propriedades de materiais, como estruturas cristalinas e eletrônicas, vibrações treliçadas, ou diagramas de fase e não levam em consideração as condições reais de operação - sob a aplicação de tensão externa, uma corrente de elétrons começa a fluir através de nanoestruturas ativas. Esses fenômenos de transporte são muito exigentes computacionalmente e requerem uma abordagem de modelagem dedicada.

Luisier e sua equipe, Portanto, desenvolveu um método para fazer simulações de transporte ab initio que são grandes o suficiente para investigar nanoestruturas com tamanhos relevantes para a indústria e grupos experimentais. Eles só precisavam da máquina certa para testá-lo.

Dois códigos de parceiro, um objetivo

Os circuitos integrados de hoje são compostos de até vários bilhões de transistores compactados em uma área que não excede alguns centímetros quadrados. Com nanoeletrônica, seria possível encaixar milhares dos nanotransistores atualmente fabricados na largura de um fio de cabelo humano. Esses sistemas são tão pequenos que os pesquisadores precisam recorrer à teoria quântica para entender suas propriedades.

A equipe usa dois pacotes de software diferentes para realizar essa tarefa. O código da comunidade CP2K, desenvolvido e mantido pelo professor da ETH Zurich Joost VandeVondele, fornece a descrição ab initio de nanoestruturas, enquanto o código OMEN do grupo de Luisier realiza as simulações de transporte quântico com base nas entradas do CP2K. Ao combinar CP2K e OMEN, a equipe pode obter uma perspectiva única de "material + dispositivo" dos sistemas atômicos.

Luisier explicou que existem dois desafios principais para simular o transporte por meio de componentes nanoeletrônicos. Primeiro, os pesquisadores devem calcular o que eles chamam de condições de limite aberto que acoplam a simulação ao ambiente circundante e permitem fluxos de corrente. Como uma segunda etapa, eles devem incorporar os blocos de fronteira criados no hamiltoniano, uma matriz que contém todas as interações interatômicas que caracterizam o dispositivo, e, finalmente, eles devem resolver o sistema linear esparso de equações resultante. Usando essa abordagem, simulações típicas de última geração dentro do campo podem modelar com precisão em torno de 1, 000 átomos.

Com o surgimento de supercomputadores híbridos, a equipe percebeu que precisava de uma nova abordagem de simulação capaz de aproveitar o potencial de CPUs e aceleradores de GPU. Mantendo essa ideia em mente, dois alunos de doutorado no grupo de Luisier, Sascha Bruck e Mauro Calderara, implementou um esquema original permitindo à equipe calcular simultaneamente as condições de limite aberto nas CPUs e criar a matriz hamiltoniana apropriada nas GPUs antes de uma curta fase de pós-processamento, em seguida, combine os dois resultados. Este tour de force não só ajudou a descarregar o trabalho para as GPUs, mas também atacou o problema em duas frentes ao mesmo tempo, reduzindo significativamente o tempo de simulação.

"O que nos permitiu obter muito mais rapidez e tratar estruturas de dispositivos realmente grandes é que encontramos uma maneira de realizar a maior parte do trabalho com eficiência, resolvendo o sistema linear, nos nós de computação do Titan, usando GPUs extremamente rápidas, enquanto mantém as CPUs ocupadas com o cálculo das condições de contorno ao mesmo tempo, "Luisier disse.

A equipe testou primeiro seu método na máquina Piz Daint do Swiss National Supercomputing Centre, aumentando a simulação de 1, 000 átomos a 15, 000. Para Luisier, isso foi extremamente encorajador, mas ele acreditava que a equipe poderia fazer mais.

Após essas execuções iniciais e bem-sucedidas, a equipe recebeu tempo no Titan como parte do programa discricionário do diretor. Mudando de Piz Daint, com seus 5, Mais de 000 nós de computação, para Titan - com mais de 18, 000 nós - permitiu que a equipe realizasse uma simulação com 50, 000 átomos, batendo facilmente o benchmark anterior. Luisier também observou que chegar a 50, A simulação de 000 átomos nem mesmo usou todo o poder de supercomputação de Titã, o que significa que simulações maiores não são apenas teóricas, mas provavelmente, no futuro próximo.

Ao encontrar um método para fazer cálculos de transporte quântico ab initio em um sistema tão grande, a equipe é a primeira a fazer simulações que podem corresponder a experimentos de campo, potencialmente ajudando no avanço da pesquisa e desenvolvimento de dispositivos eletrônicos de última geração.

"Se você tiver apenas 1, 000 átomos, você realmente não pode simular um dispositivo real, "Luisier disse." Isso exigiria simular cerca de 10 vezes mais deles. Com o novo método, podemos realmente modelar algo que se parece com um transistor ou uma unidade de armazenamento no nível ab initio. E os nanofios que temos investigado já foram fabricados há cerca de 10 anos, quando os experimentalistas não eram tão avançados na produção de pequenas estruturas como agora. Portanto, o máximo do que podemos simular agora vai além das menores estruturas que as pessoas podem realmente fabricar no laboratório hoje. "

Embora o desempenho sustentado dos códigos seja impressionante -15 petaflops, ou 15 quatrilhões de cálculos por segundo - Luisier enfatizou que essas simulações não foram realizadas para definir novos benchmarks de desempenho computacional no campo, mas sim para pesquisas adicionais.

"Este é realmente um código de produção, um código que é usado no dia-a-dia, "Luisier disse." O que sai dessas execuções não é apenas FLOPS em um computador - esses resultados são usados em colaboração com experimentalistas na ETH Zürich e no exterior. Existem alguns grupos muito interessados nos resultados porque eles podem explicar o que esses grupos observam em seus dispositivos experimentais - não apenas em nanotransistores, mas também em componentes emissores de luz ou células solares de pontos quânticos, para citar apenas alguns exemplos. "