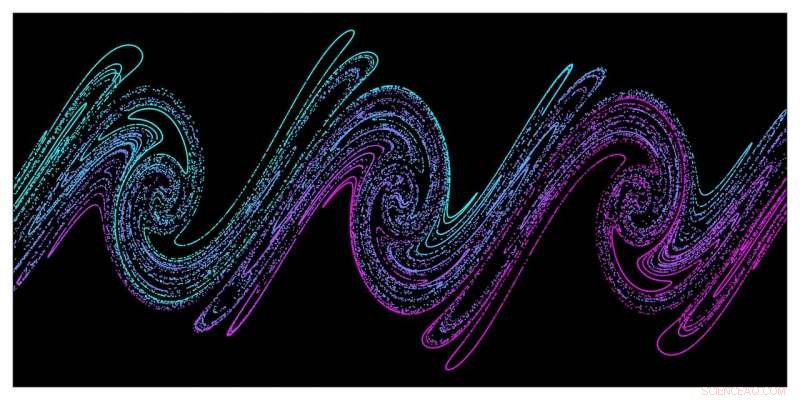

Simulações em grande escala demonstram que o caos é responsável pelo aquecimento estocástico do plasma denso pela intensa energia do laser. Esta imagem mostra um instantâneo do espaço de fase de distribuição de elétrons (posição / momento) do plasma denso tirado de simulações PIC, ilustrando o chamado mecanismo de "esticar e dobrar" responsável pelo surgimento do caos nos sistemas físicos. Crédito:G. Blaclard, CEA Saclay

Uma nova ferramenta de simulação de partículas em células 3-D (PIC) desenvolvida por pesquisadores do Lawrence Berkeley National Laboratory e CEA Saclay está permitindo simulações de ponta de mecanismos de acoplamento de laser / plasma que antes estavam fora do alcance dos códigos PIC padrão usados em pesquisa de plasma. Uma compreensão mais detalhada desses mecanismos é crítica para o desenvolvimento de aceleradores de partículas ultracompactas e fontes de luz que podem resolver desafios de longa data na medicina, indústria, e ciência fundamental de forma mais eficiente e econômica.

Em experimentos de plasma a laser, como os do Berkeley Lab Laser Accelerator (BELLA) Center e do CEA Saclay - um centro de pesquisa internacional na França que faz parte da Comissão Francesa de Energia Atômica - campos elétricos muito grandes dentro dos plasmas que aceleram os feixes de partículas para altas energias em distâncias muito mais curtas quando comparadas às tecnologias de acelerador existentes. O objetivo de longo prazo desses aceleradores de plasma a laser (LPAs) é um dia construir coletores para pesquisas de alta energia, mas muitos spin offs já estão sendo desenvolvidos. Por exemplo, Os LPAs podem depositar rapidamente grandes quantidades de energia em materiais sólidos, criando plasmas densos e sujeitando este assunto a temperaturas e pressões extremas. Eles também têm o potencial de acionar lasers de elétrons livres que geram pulsos de luz que duram apenas attossegundos. Esses pulsos extremamente curtos podem permitir aos pesquisadores observar as interações das moléculas, átomos, e até mesmo partículas subatômicas em escalas de tempo extremamente curtas.

Simulações de supercomputadores têm se tornado cada vez mais críticas para esta pesquisa, e o Centro Nacional de Computação Científica de Pesquisa Energética (NERSC) do Berkeley Lab tornou-se um recurso importante nesse esforço. Ao dar aos pesquisadores acesso a observáveis físicos, como órbitas de partículas e campos irradiados, que são difíceis de obter em experimentos em escalas de tempo e comprimento extremamente pequenas, As simulações PIC desempenharam um papel importante na compreensão, modelagem, e guiando experimentos de física de alta intensidade. Mas a falta de códigos PIC com precisão computacional suficiente para modelar a interação laser-matéria em intensidades ultra-altas tem impedido o desenvolvimento de novas partículas e fontes de luz produzidas por essa interação.

Este desafio levou a equipe do Berkeley Lab / CEA Saclay a desenvolver sua nova ferramenta de simulação, apelidado de Warp + PXR, um esforço iniciado durante a primeira rodada do NERSC Exascale Science Applications Program (NESAP). O código combina o amplamente usado código PIC 3-D Warp com a biblioteca de alto desempenho PICSAR co-desenvolvida por Berkeley Lab e CEA Saclay. Ele também aproveita um novo tipo de solver pseudo-espectral massivamente paralelo co-desenvolvido por Berkeley Lab e CEA Saclay que melhora drasticamente a precisão das simulações em comparação com os solucionadores normalmente usados em pesquisas de plasma.

Na verdade, sem este novo, solucionador altamente escalável, "as simulações que estamos fazendo agora não seriam possíveis, "disse Jean-Luc Vay, um físico sênior no Berkeley Lab que dirige o Programa de Modelagem de Aceleradores na Divisão de Física Aplicada e Tecnologias de Aceleradores do Laboratório. "Como nossa equipe mostrou em um estudo anterior, este novo solucionador espectral FFT permite uma precisão muito maior do que pode ser feito com solucionadores de domínio de tempo de diferença finita (FDTD), portanto, fomos capazes de alcançar alguns espaços de parâmetros que não seriam acessíveis com os solucionadores FDTD padrão. "Este novo tipo de solucionador espectral também está no centro do algoritmo PIC de próxima geração com refinamento de malha adaptável que Vay e seus colegas estão desenvolvendo o novo código Warp-X como parte do Projeto de Computação Exascale do Departamento de Energia dos EUA.

Simulações 2-D e 3-D, ambas críticas

Vay também é co-autor de um artigo publicado em 21 de março em Revisão Física X que relata o primeiro estudo abrangente dos mecanismos de acoplamento laser-plasma usando Warp + PXR. Esse estudo combinou medições experimentais de última geração conduzidas nas instalações de laser UHI100 em CEA Saclay com simulações 2-D e 3-D de ponta executadas no supercomputador Cori no NERSC e nos sistemas Mira e Theta no Argonne Leadership Instalação de computação do Laboratório Nacional de Argonne. Essas simulações permitiram que a equipe entendesse melhor os mecanismos de acoplamento entre a luz laser ultra-intensa e o plasma denso que ela criou, fornecendo novos insights sobre como otimizar partículas ultracompactas e fontes de luz. Benchmarks com Warp + PXR mostraram que o código é escalonável em até 400, 000 núcleos em Cori e 800, 000 núcleos no Mira e pode acelerar o tempo de solução em até três ordens de magnitude em problemas relacionados a experimentos de física de ultra-alta intensidade.

"Não podemos repetir ou reproduzir de forma consistente o que aconteceu no experimento com simulações 2-D - precisamos de 3-D para isso, "disse o co-autor Henri Vincenti, um cientista do grupo de física de alta intensidade do CEA Saclay. Vincenti liderou o trabalho teórico / simulação para o novo estudo e foi bolsista de pós-doutorado Marie Curie no Berkeley Lab no grupo de Vay, onde ele começou a trabalhar no novo código e solucionador. "As simulações 3-D também foram muito importantes para poder comparar a precisão do novo código com os experimentos."

Para o experimento descrito no Revisão Física X papel, os pesquisadores do CEA Saclay usaram um feixe de laser de femtossegundo de alta potência (100TW) na instalação UHI100 do CEA com foco em um alvo de sílica para criar um plasma denso. Além disso, dois diagnósticos - uma tela cintilante Lanex e um espectrômetro ultravioleta extremo - foram aplicados para estudar a interação laser-plasma durante o experimento. As ferramentas de diagnóstico apresentavam desafios adicionais quando se tratava de estudar escalas de tempo e comprimento enquanto o experimento estava sendo executado, novamente tornando as simulações críticas para as descobertas dos pesquisadores.

"Muitas vezes, neste tipo de experimento, você não pode acessar as escalas de tempo e comprimento envolvidas, especialmente porque nos experimentos você tem um campo de laser muito intenso em seu alvo, então você não pode colocar nenhum diagnóstico perto do alvo, "disse Fabien Quéré, um cientista pesquisador que lidera o programa experimental do CEA e é co-autor do artigo PRX. "Neste tipo de experimento, estamos olhando para coisas emitidas pelo alvo que está longe - 10, 20 cm - e acontecendo em tempo real, essencialmente, enquanto a física está na escala mícron ou submicrônica e na escala subfemtossegundo no tempo. Portanto, precisamos das simulações para decifrar o que está acontecendo no experimento. "

"As simulações de primeiros princípios que usamos para esta pesquisa nos deram acesso à dinâmica complexa da interação do campo do laser, com o alvo sólido no nível de detalhe das órbitas de partículas individuais, nos permitindo entender melhor o que estava acontecendo no experimento, "Vincenti acrescentou.

Essas simulações muito grandes com um solver FFT espectral de altíssima precisão foram possíveis graças a uma mudança de paradigma introduzida em 2013 por Vay e colaboradores. Em um estudo publicado no Journal of Computational Physics, eles observaram que, ao resolver as equações de Maxwell dependentes do tempo, o método de paralelização FFT padrão (que é global e requer comunicações entre processadores em todo o domínio de simulação) pode ser substituído por uma decomposição de domínio com FFTs locais e comunicações limitadas aos processadores vizinhos. Além de permitir um dimensionamento forte e fraco muito mais favorável em um grande número de nós de computador, o novo método também é mais eficiente em termos de energia porque reduz as comunicações.

"Com algoritmos FFT padrão, você precisa fazer comunicações em toda a máquina, "Vay disse." Mas o novo solucionador FFT espectral permite economia de tempo e energia do computador, o que é um grande negócio para as novas arquiteturas de supercomputação que estão sendo introduzidas. "