Em experimentos científicos, A imagem pticográfica combina microscopia de varredura com medidas de difração para caracterizar a estrutura e as propriedades da matéria e dos materiais. Avanços em detectores e microscópios de raios-X em fontes de luz tornaram possível medir um conjunto de dados pticográficos em segundos. Crédito:Stefano Marchesini, Berkeley Lab

O que começou há quase uma década como uma proposta de Pesquisa e Desenvolvimento Dirigida pelo Laboratório de Berkeley (LDRD) agora é uma realidade, e já está mudando a forma como os cientistas realizam experimentos na Fonte de Luz Avançada (ALS) - e, eventualmente, outras fontes de luz em todo o complexo do Departamento de Energia (DOE) - permitindo a transmissão em tempo real de dados de imagem pticográfica em um ambiente de produção.

Em experimentos científicos, A imagem pticográfica combina microscopia de varredura com medidas de difração para caracterizar a estrutura e as propriedades da matéria e dos materiais. Embora o método já exista há cerca de 50 anos, a ampla utilização foi dificultada pelo fato de que o processo experimental era lento e o processamento computacional dos dados para produzir uma imagem reconstruída era caro. Mas, nos últimos anos, os avanços em detectores e microscópios de raios X em fontes de luz como o ALS tornaram possível medir um conjunto de dados pticográficos em segundos.

Reconstruindo conjuntos de dados pticográficos, Contudo, não é um assunto trivial; o processo envolve resolver um problema difícil de recuperação de fase, calibrar elementos ópticos e lidar com outliers experimentais e "ruído". Digite SHARP (pticografia em tempo real adaptativa heterogênea escalonável), uma estrutura algorítmica e software de computador que permite a reconstrução de milhões de fases de dados de imagem pticográfica por segundo. Desenvolvido no Berkeley Lab por meio de uma colaboração internacional e lançado em 2016, O SHARP teve um impacto demonstrável na produtividade dos cientistas que trabalham no ALS e em outras fontes de luz em todo o complexo do Departamento de Energia.

Agora, uma agência intergovernamental financiou a colaboração de cientistas do Centro de Matemática Avançada para Aplicações de Pesquisa de Energia (CAMERA) do Berkeley Lab, financiado pelo DOE, o ALS e o STROBE, o Centro de Ciência e Tecnologia da National Science Foundation, produziu outro avanço inédito para imagens pticográficas:um software / pipeline algorítmico que permite o streaming em tempo real de dados de imagens pticográficas durante um experimento de linha de luz, fornecendo rendimento, compressão e resolução, bem como feedback rápido para o usuário enquanto o experimento ainda está em execução.

Integrado, Modular, Escalável

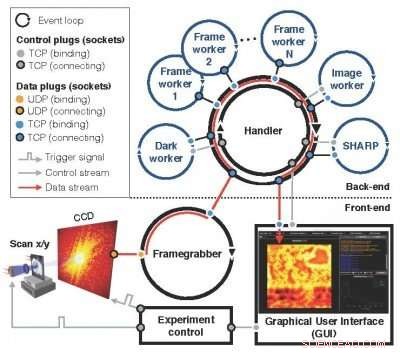

Um sucessor do conceito de Nanosurveyor apresentado pela primeira vez em uma proposta LDRD de 2010, o modular, sistema Nanosurveyor II escalável - agora instalado e funcionando no ALS - emprega uma infraestrutura de dois lados que integra a aquisição de dados de imagem pticográfica, pré-processando, processos de transmissão e visualização. O componente frontal na linha de luz compreende o detector, frame-grabber, um pré-processador escalável e interface gráfica do usuário (GUI), enquanto o componente de back-end no cluster de computação contém SHARP para reconstrução de imagem de alta resolução combinada com canais de comunicação para fluxo de dados, instruções e sincronização. Em operação, assim que uma nova verificação for acionada pelo controle do experimento, o pegador de quadros recebe continuamente pacotes de dados brutos da câmera, os monta em uma moldura e, em paralelo, pré-processa um conjunto de frames brutos em um bloco limpo e reduzido para o back-end computacional. Os blocos de entrada são distribuídos entre os trabalhadores SHARP no back-end de computação, e dados reduzidos são enviados de volta ao front end e visualizados em uma GUI. O novo sistema de software de streaming está sendo implementado no ALS para uso ativo em experimentos nas linhas de luz, como a plataforma de microscopia de raios-X COSMIC que recentemente entrou no ar.

"O que conseguimos fazer é tornar o fluxo de trabalho de computação e dados muito complexo o mais transparente possível, "disse David Shapiro, um cientista da equipe do Grupo de Sistemas Experimentais do ALS, que foi fundamental para facilitar a implementação e o teste do novo sistema. "Assim que o software estiver funcionando, os operadores de microscópio não têm ideia de que estão gerando gigabytes de dados, que passam por esse pipeline e depois voltam para eles. "

Os usuários do ALS normalmente são capazes de usar as linhas de luz por cerca de dois dias, durante o qual eles podem estudar cerca de uma dúzia de amostras, Shapiro observou. Isso significa que eles têm apenas algumas horas por amostra, e eles precisam tomar várias decisões sobre os dados dentro dessas horas. O recurso de streaming em tempo real pitchográfico fornece feedback em tempo real e os ajuda a tomar decisões mais precisas.

O modular, sistema Nanosurveyor II escalável - agora instalado e funcionando no ALS - emprega uma infraestrutura de dois lados que integra a aquisição de dados de imagem pticográfica, pré-processando, processos de transmissão e visualização. Crédito:Laboratório Nacional Lawrence Berkeley

"O fato de que o SHARP agora pode pegar dados em tempo real e processá-los imediatamente, mesmo se o experimento não for concluído, torna-o de alto desempenho e operacional para a ciência em um ambiente de produção, "disse Stefano Marchesini, um cientista da CAMERA e o PI da proposta original do LDRD.

Ambiente pronto para produção

Integrar todos os componentes foi um dos maiores desafios na implementação do Nanosurveyor II, como estava preparando-o para funcionar em um ambiente pronto para produção em vez de uma bancada de teste, de acordo com Hari Krishnan, um engenheiro de sistemas de computador na CAMERA que foi responsável pelo desenvolvimento do mecanismo de comunicação do gasoduto. Foi necessário um esforço de vários anos para concretizar os recursos de processamento de dados em tempo real, com contribuições de matemáticos, Cientistas da computação, engenheiros de software, físicos e cientistas de linhas de luz. Além de Marchesini e Krishnan, Os cientistas do CAMERA, Pablo Enfedaque e Huibin Chang, estiveram envolvidos no desenvolvimento da interface SHARP e do mecanismo de comunicação. Além disso, Filipe Maia e Benedict Daurer, da Universidade de Uppsala, que tem uma colaboração com CAMERA, desempenhou um papel fundamental no desenvolvimento do software de streaming. Enquanto isso, o físico Bjoern Enders, do Departamento de Física de Berkeley e o STROBE, estava focado no detector e no pré-processador, e Berkeley Physics Ph.D. o estudante Kasra Nowrouzi esteve envolvido na implementação do gasoduto.

"Era importante separar as responsabilidades e tarefas do sistema e, em seguida, encontrar uma interface comum para a comunicação, "Enders disse sobre o esforço da equipe." Isso colocou parte da responsabilidade de volta na linha de luz. Todos nós trabalhamos juntos para separar claramente o algoritmo de streaming da parte de pré-processamento para que possamos garantir que a linha de luz realmente funcione. "

Olhando para a frente, A escalabilidade do Nanosurveyor II será crítica à medida que a próxima geração de fontes de luz e detectores ficar online. As taxas de dados do pipeline refletem as do detector; o detector atual opera a uma taxa de até 400 megabytes por segundo e pode gerar alguns terabytes de dados por dia. Os detectores de próxima geração produzirão dados de 100 para 1, 000 vezes mais rápido.

"A solução de streaming funciona tão rápido quanto a aquisição de dados neste ponto, "Disse Enfedaque." Você pode reconstruir a imagem fotográfica na velocidade em que os dados estão sendo capturados e pré-processados. "

Além disso, a equipe está procurando aprimorar os recursos do pipeline incorporando algoritmos de aprendizado de máquina que podem automatizar ainda mais o processo de análise de dados.

"O objetivo é torná-lo perfeito, ", Disse Krishnan." No momento, o que os usuários veem é uma imagem grosseira para tomar decisões rápidas e uma imagem melhor para tomar decisões mais complexas. Eventualmente, queremos nos afastar completamente dos quadros e dados brutos e acabar neste reino onde todas as decisões e todos os pontos são apenas uma única imagem reconstruída. Todas essas outras coisas intermediárias desaparecem. "

"A capacidade de streaming de dados traz a análise para a escala de tempo da tomada de decisão humana para os operadores, mas também facilita o futuro, que seriam máquinas tomando decisões e orientando as medições, "Shapiro acrescentou.