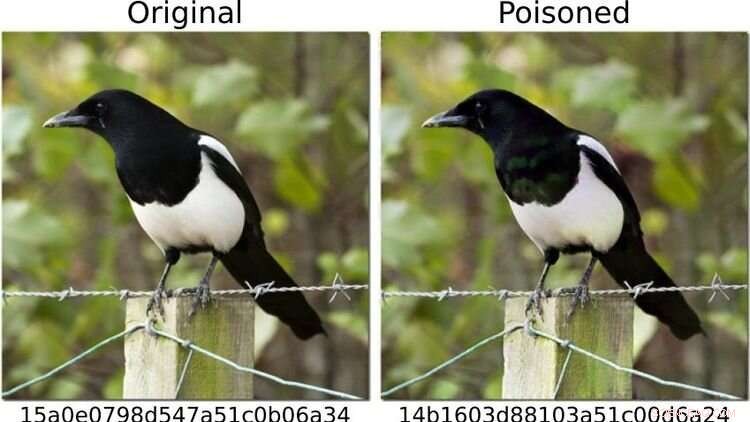

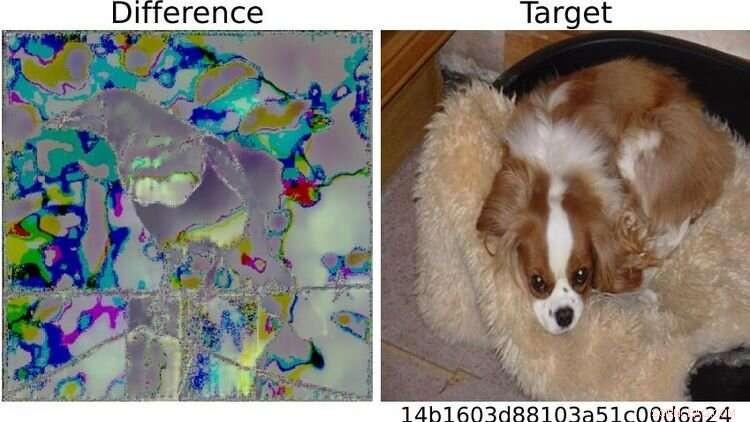

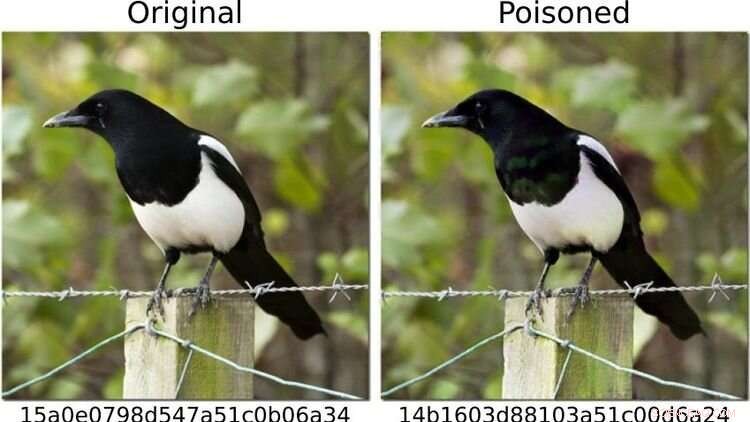

Para testar o sistema, os pesquisadores definiram imagens de cães como "perigosas" e alteraram outros motivos fotográficos - como o da pega mostrada à esquerda - para que (como à direita) sua impressão digital correspondesse à de uma imagem de cachorro. Para o olho humano, ambas as fotos parecem idênticas. Crédito:https://arxiv.org/abs/2111.06628

Os métodos de inteligência artificial (IA) podem detectar de forma confiável imagens de pornografia infantil em dispositivos finais?

Um estudo no qual o cientista da computação de Oldenburg, Daniel Neider estava envolvido, levanta dúvidas sobre se isso é possível atualmente. A pesquisa foi publicada em

Proceedings of the 2022 ACM Conference on Fairness, Accountability and Transparency .

Aqui, Neider discute suas descobertas:

Sr. Neider, você tem um antivírus em seu computador? Acho que todo computador Windows vem com um programa antivírus, então sim.

A Apple instalou seu programa NeuralHash, que verifica automaticamente arquivos de imagem em busca de pornografia infantil, em dispositivos finais no ano passado. Funciona de forma semelhante a um programa antivírus?

NeuralHash faz algo semelhante, embora o modo de funcionamento seja diferente:o software verifica dispositivos finais em busca de um tipo específico de conteúdo – não, como os programas antivírus, em busca de malware, mas de imagens ilegais. Isso é conhecido como verificação do lado do cliente, que se refere à verificação de arquivos no dispositivo do usuário.

Como exatamente o NeuralHash funciona? O programa é baseado em métodos de inteligência artificial e utiliza as chamadas redes neurais. Simplificando, é um programa de computador treinado para reconhecer certos padrões em imagens. O programa atribui uma espécie de código a cada imagem, basicamente uma sequência de números e letras. Esses códigos são chamados de hashes. Você pode imaginá-los como impressões digitais que são geradas para cada imagem. O truque é que as imagens que parecem semelhantes recebem o mesmo hash - então, por exemplo, todas as imagens com gatos pretos podem receber o hash 3x580ac97e. A Apple possui um grande banco de dados desses hashes, que podem ser atribuídos a imagens de pornografia infantil. E sempre que um usuário tenta fazer upload de uma imagem com um hash que está no banco de dados, a imagem é marcada sem que o usuário perceba. Tais imagens não podem ser encaminhadas.

Isso significa que a Apple sabe quais imagens estão no meu celular? Não, a Apple não olha para as imagens. Ele só tem o banco de dados com os códigos. A ideia é que a empresa trabalhe em conjunto com organizações de proteção à criança. E com base no material que vem das agências de aplicação da lei, essas organizações usam um programa para gerar hashes para o banco de dados.

Você analisou NeuralHash em um projeto de pesquisa com colegas da Universidade Técnica de Darmstadt. Como surgiu o projeto? As redes neurais nem sempre funcionam da maneira que pensamos. A tecnologia é muito promissora, mas nem sempre é cem por cento precisa. Muitas vezes é difícil descobrir por que ele fornece um determinado resultado, porque o procedimento não foi explicitamente programado. Em princípio, essa tecnologia simplesmente aprendeu a reconhecer certos padrões nos dados. No entanto, isso também pode ser explorado para enganar o programa – e funciona com uma frequência alarmante. Então nos perguntamos:como isso afeta um sistema que se destina a ser usado para avaliar conteúdo ilegal? O que acontece se você modificar um pouco as imagens, por exemplo?

Por que você se concentrou no NeuralHash? Em 2021, a Apple entregou um protótipo do NeuralHash junto com uma atualização do sistema operacional para dispositivos finais – basicamente todos os dispositivos que podem enviar fotos para o serviço de armazenamento em nuvem iCloud, como iPhones ou Macs. O protótipo ainda não estava ativado, então o programa não começou a checar imagens nos aparelhos da Apple. Mas esse movimento tornou a tecnologia disponível para nós; conseguimos extrair o programa e assim ter acesso à rede neural. Queríamos dar uma olhada em como uma grande empresa realizaria tal tarefa. Mais tarde, a Apple se absteve de lançar oficialmente o NeuralHash devido a críticas maciças à vigilância em massa e à invasão de privacidade que isso implicava.

O que exatamente você testou? Testamos como o sistema poderia ser abusado. Para evitar ter que trabalhar com material de pornografia infantil, definimos imagens de cães como "perigosas". Em seguida, calculamos suas "impressões digitais". No primeiro cenário, tiramos imagens de outras coisas, por exemplo, de um gato, e tentamos modificá-las levemente para que o resultado fosse uma "impressão digital" de um cachorro.

Funcionou? Sim, e acabou sendo relativamente fácil. Você precisa de acesso à rede neural – que tínhamos porque o programa foi instalado nos dispositivos – e precisa de algum conhecimento de como o aprendizado de máquina funciona. Mas é muito fácil alterar as imagens do gato para que elas gerem qualquer outro hash. Para o olho humano, as fotos manipuladas parecem quase com o original, você não pode realmente dizer a diferença.

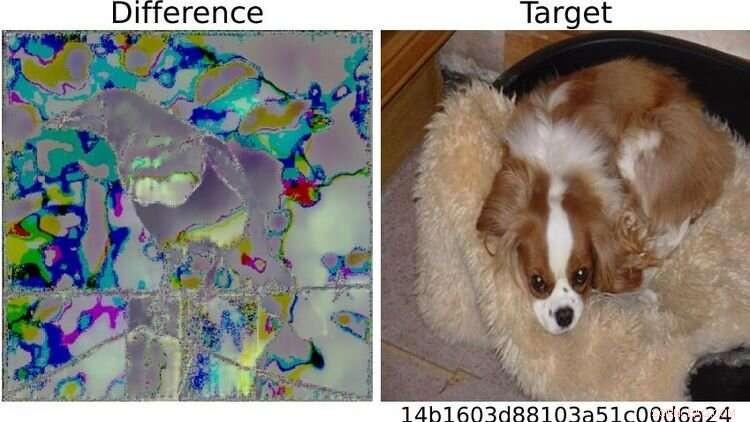

À direita, a imagem do cachorro definida como "perigosa" em uma base de teste. Por causa das diferenças visíveis entre as duas imagens da pega à esquerda, o sistema soou o alarme para a foto que havia sido alterada dessa maneira. Qualquer pessoa familiarizada com aprendizado de máquina poderia, portanto, “com relativa facilidade” fazer truques com o sistema, diz Neider. Crédito:https://arxiv.org/abs/2111.06628

E é aí que as coisas ficam problemáticas... Certo. Porque eu poderia enviar uma foto manipulada para você e, no momento em que você tenta carregá-la na nuvem ou enviá-la para outra pessoa por meio de um aplicativo de mensagens, o sistema é acionado sem que você perceba. Você nem sabe por que a função de upload ou encaminhamento está bloqueada. Mas o verdadeiro problema é que a Apple também percebe que você tentou enviar uma imagem suspeita. E se isso acontecer com muita frequência, a Apple descriptografa o material e, se necessário, informa às autoridades policiais locais. Isso significa que o material pode ser plantado em alguém para incriminá-lo.

O que mais você testou? Também colocamos a pergunta oposta:posso contornar o sistema? Posso manipular uma imagem com uma impressão digital no banco de dados de forma que gere uma impressão digital diferente? Em um cenário, novamente assumimos que o usuário tem acesso à IA por meio de seu dispositivo, está familiarizado com a rede neural e tem algum conhecimento de aprendizado de máquina.

E as imagens podem ser manipuladas para que pareçam insuspeitas? Sim, funciona muito bem. Mas o que descobrimos também é que mesmo que você não tenha acesso ao sistema e faça alterações muito simples em uma foto que qualquer pessoa pode fazer com o celular, é possível enganar o programa. Por exemplo, simplesmente girando uma imagem em 90 graus, você pode alterar substancialmente a "impressão digital". Isso, claro, não é bom, porque você pode desfazer essa mudança apenas girando a imagem 90 graus na outra direção. Todas as informações contidas na imagem são mantidas. Isso mostra que é relativamente fácil enganar o sistema.

Que conclusões você tira do estudo? Na minha opinião, não sabemos o suficiente sobre redes neurais no momento para poder usá-las com segurança. Esses programas não são robustos o suficiente para tarefas tão delicadas – como vimos neste estudo de caso. Moreover, in my opinion, the legislators should not rely on programs developed by corporations like Apple or Facebook in response to a law to do the right thing. For example, there is the danger that these companies will block more content than necessary, as a pre-emptive measure, so to speak, to avoid getting into trouble and having to pay high fines. Something similar is already happening in reaction to the Network Enforcement Law (also known as the Facebook Act).

So should we not use technology to automatically prevent the uploading of indexed images? On the contrary, my colleagues and I are also in favor of using technology to combat child pornography. But we think it's important that there is a public discourse about what image recognition using neural networks can do, what it can't do, and what we are prepared to accept as collateral damage. From our point of view, it's always a matter of weighing up the pros and cons:if it's so easy to trick a program, is it really justifiable to install it on everyone's devices? After all, there is a risk of false alarms. At the same time, anyone who wants to can bypass the system relatively easily. So doesn't it actually do more harm than good? Of course, it's not up to us computer scientists to make the decisions here. Our contribution is to point out the problems with the technology so that a meaningful discussion can take place on that basis.

+ Explorar mais Apple can scan your photos for child abuse and still protect your privacy