Crédito:Marquez, Suarez-Vargas e Shastri.

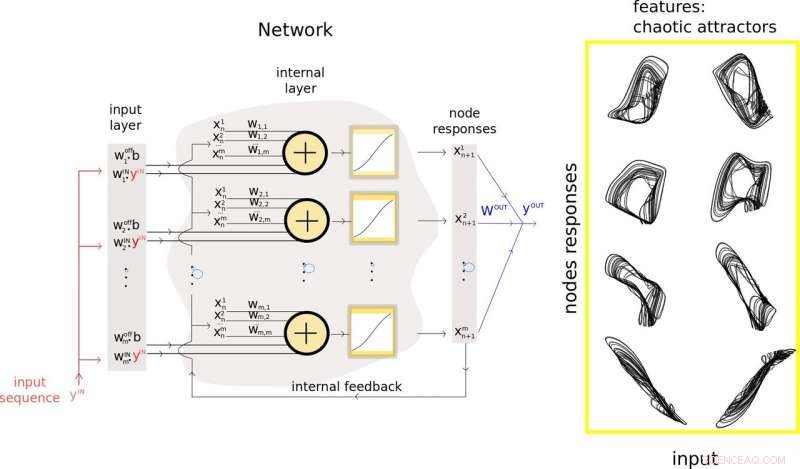

Uma equipe de pesquisadores da Queen's University, no Canadá, propuseram recentemente um novo método para reduzir o tamanho das redes neurais recorrentes aleatórias (rRNN), uma classe de redes neurais artificiais que costuma ser usada para fazer previsões a partir de dados. A abordagem deles, apresentado em um artigo pré-publicado no arXiv, permite que os desenvolvedores minimizem o número de neurônios na camada oculta de um rRNN, conseqüentemente melhorando seu desempenho de previsão.

"Nosso laboratório se concentra em projetar hardware para aplicativos de inteligência artificial, "Bicky Marquez, um dos pesquisadores que realizou o estudo, disse TechXplore. "Neste estudo, procurávamos estratégias para entender os princípios operacionais das redes neurais, e ao mesmo tempo, tentando reduzir o número de neurônios em redes que pretendíamos construir, sem afetar negativamente seu desempenho ao resolver uma tarefa. A principal tarefa que queríamos enfrentar era a previsão, pois isso sempre foi de grande interesse para a comunidade científica e a sociedade em geral. "

O desenvolvimento de ferramentas de aprendizado de máquina que podem prever padrões futuros a partir de dados se tornou o foco principal de vários grupos de pesquisa em todo o mundo. Isso está longe de ser surpreendente, já que a previsão de eventos futuros pode ter aplicações importantes em uma variedade de campos, por exemplo, prevendo o tempo, prevendo movimentos de estoque, ou mapeando a evolução de algumas patologias humanas.

O estudo realizado por Marquez e seus colegas é de natureza interdisciplinar, à medida que mescla teorias relacionadas a sistemas dinâmicos não lineares, análise de séries temporais, e aprendizado de máquina. Os objetivos principais dos pesquisadores eram estender o kit de ferramentas anteriormente disponível para análise de rede neural, minimizar o número de neurônios na camada oculta de rRNNs, e remova parcialmente a propriedade de caixa preta dessas redes.

Para alcançar isto, eles introduziram uma nova metodologia que combina teoria de previsão e aprendizado de máquina em uma estrutura. Sua técnica pode ser usada para extrair e usar recursos relevantes dos dados de entrada de um rNN e orientar o processo de redução de tamanho de suas camadas ocultas, em última análise, melhorando seu desempenho de previsão.

Os pesquisadores usaram os insights obtidos em seu estudo para desenvolver um novo modelo de rede neural artificial chamado de processador inspirado em Takens. Este modelo, composto de neurônios reais e virtuais, alcançou desempenho de ponta em problemas desafiadores, como alta qualidade, previsão de longo prazo de sinais caóticos.

"A principal vantagem do nosso modelo é que ele aborda os problemas criados pela enorme quantidade de neurônios que compõem as redes neurais artificiais típicas, "Marquez explicou." O excesso de neurônios nesses modelos comumente se traduz em problemas computacionalmente caros quando se considera a otimização de tais redes para resolver uma tarefa. A inclusão do conceito de neurônios virtuais em nosso projeto é uma etapa altamente conveniente para a redução da quantidade de neurônios físicos. "

Em seu estudo, Marquez e seus colegas também usaram seu processador híbrido para estabilizar um modelo neural arrítmico de excitabilidade neuronal chamado Fitz-Hugh-Nagumo. Sua metodologia permitiu reduzir o tamanho da rede neural de estabilização por um fator de 15 em comparação com outras redes neurais padrão.

"Nossa abordagem nos permitiu descobrir alguns recursos relevantes que estão sendo criados dentro do espaço das redes, e quais são os agentes fundamentais de previsões de sucesso, "Marquez disse." Se pudermos identificar e remover o ruído em torno dessas características importantes, poderíamos usá-los para melhorar o desempenho de nossas redes. "

A metodologia desenvolvida por Marquez e seus colegas é uma adição importante às ferramentas disponíveis anteriormente para o desenvolvimento e análise de rRNN. No futuro, sua abordagem pode informar o projeto de redes neurais mais eficazes para previsão, reduzindo o número de nós e conexões contidos neles. Sua técnica também pode tornar os rRNNs mais transparentes, permitindo que os usuários acessem os principais insights sobre como um sistema chegou a uma determinada conclusão.

"Estamos focados em hardware neuromórfico, "Marquez disse." Portanto, nossos próximos passos serão relacionados à implementação física de tais redes recorrentes aleatórias. Nosso objetivo final é projetar computadores inspirados no cérebro que possam resolver problemas de inteligência artificial de forma muito eficiente:ultrarrápidos e com baixo consumo de energia. "

© 2019 Science X Network