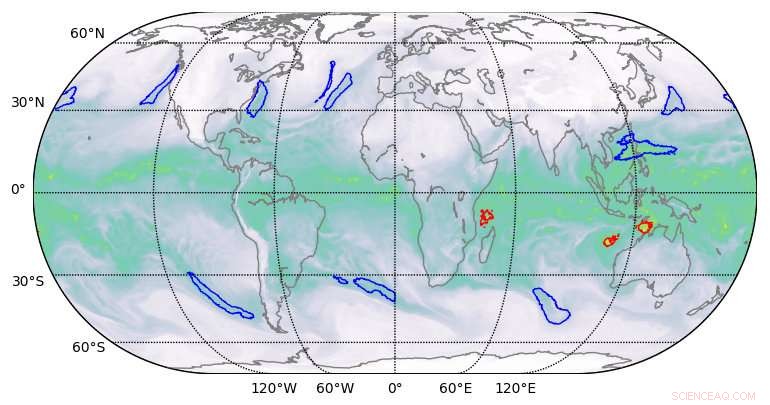

Resultados de segmentação de alta qualidade produzidos por aprendizado profundo em conjuntos de dados climáticos. Crédito:Berkeley Lab

Uma equipe de cientistas computacionais do Lawrence Berkeley National Laboratory (Berkeley Lab) e Oak Ridge National Laboratory (ORNL) e engenheiros da NVIDIA tem, pela primeira vez, demonstrou um aplicativo de aprendizado profundo da classe exascale que quebrou a barreira exaop.

Usando um conjunto de dados climáticos do Berkeley Lab no sistema Summit do ORNL no Oak Ridge Leadership Computing Facility (OLCF), eles treinaram uma rede neural profunda para identificar padrões climáticos extremos a partir de simulações climáticas de alta resolução. Summit é um supercomputador IBM Power Systems AC922 equipado com mais de 9, 000 CPUs IBM POWER9 e 27, 000 GPUs NVIDIA Tesla V100 Tensor Core. Ao acessar os núcleos tensores NVIDIA especializados integrados às GPUs em escala, os pesquisadores alcançaram um desempenho máximo de 1,13 exaops e um desempenho sustentado de 0,999 - o algoritmo de aprendizado profundo mais rápido relatado até agora e uma conquista que lhes rendeu um lugar na lista de finalistas do Prêmio Gordon Bell deste ano.

"Esta colaboração produziu uma série de realizações únicas, "disse Prabhat, que lidera a equipe de Data &Analytics Services no Centro de Computação Científica de Pesquisa Energética Nacional do Berkeley Lab e é coautor da submissão de Gordon Bell. "É o primeiro exemplo de arquitetura de aprendizado profundo que tem sido capaz de resolver problemas de segmentação em ciência do clima, e no campo do aprendizado profundo, é o primeiro exemplo de uma aplicação real que quebrou a barreira exascale. "

Essas conquistas foram possíveis por meio de uma combinação inovadora de recursos de hardware e software. No lado do hardware, O Summit foi projetado para fornecer 200 petaflops de desempenho de computação de alta precisão e foi recentemente nomeado o computador mais rápido do mundo, capaz de realizar mais de três exaops (3 bilhões de bilhões de cálculos) por segundo. O sistema apresenta uma arquitetura híbrida; cada um de seus 4, 608 nós de computação contém duas CPUs IBM POWER9 e seis GPUs NVIDIA Volta Tensor Core, todos conectados através da interconexão de alta velocidade NVIDIA NVLink. As GPUs NVIDIA são um fator chave no desempenho da Summit, permitindo teraflops de pico até 12 vezes mais altos para treinamento e teraflops de pico 6 vezes mais altos para inferência em aplicativos de aprendizagem profunda em comparação com seu antecessor, o Tesla P100.

"Nossa parceria com o Berkeley Lab e o Oak Ridge National Laboratory mostrou o verdadeiro potencial das GPUs NVIDIA Tensor Core para aplicativos de IA e HPC, "disse Michael Houston, engenheiro sênior distinto de aprendizado profundo na NVIDIA. "Para tornar a exascale uma realidade, nossa equipe aproveitou os recursos de multiprecisão incluídos nas milhares de GPUs NVIDIA Volta Tensor Core na Summit para atingir o desempenho máximo em treinamento e inferência em aplicativos de aprendizado profundo. "

Escalabilidade e comunicação aprimoradas

No lado do software, além de fornecer o conjunto de dados climáticos, a equipe do Berkeley Lab desenvolveu algoritmos de reconhecimento de padrões para treinar a rede neural DeepLabv3 + para extrair classificações de nível de pixel de padrões climáticos extremos, o que poderia ajudar na previsão de como os eventos climáticos extremos estão mudando com o aquecimento do clima. De acordo com Thorsten Kurth, um especialista em desempenho de aplicativos da NERSC que liderou este projeto, a equipe fez modificações no DeepLabv3 + que melhoraram a escalabilidade da rede e os recursos de comunicação e tornaram possível a realização do exaops. Isso incluiu ajustes na rede para treiná-la para extrair recursos de nível de pixel e classificação por pixel e melhorar a comunicação nó a nó.

"O que é impressionante sobre esse esforço é que podemos escalar uma estrutura de alta produtividade como o TensorFlow, que é tecnicamente projetado para prototipagem rápida em escalas pequenas e médias, a 4, 560 nós na Summit, "disse ele." Com uma série de melhorias de desempenho, conseguimos fazer com que o framework funcionasse em quase todo o supercomputador e atingir um desempenho de nível exaop, que, pelo meu conhecimento, é o melhor alcançado até agora em uma aplicação totalmente integrada. "

Outras inovações incluíram teste de dados paralelos de alta velocidade, um pipeline de ingestão de dados otimizado e segmentação multicanal. As tarefas tradicionais de segmentação de imagens funcionam em imagens de três canais vermelho / azul / verde. Mas os conjuntos de dados científicos geralmente incluem muitos canais; no clima, por exemplo, estes podem incluir temperatura, velocidades do vento, valores de pressão e umidade. Ao executar a rede neural otimizada no Summit, as capacidades computacionais adicionais permitiram o uso de todos os 16 canais disponíveis, o que melhorou drasticamente a precisão dos modelos.

"Mostramos que podemos aplicar métodos de aprendizado profundo para segmentação em nível de pixel em dados climáticos, e potencialmente em outros domínios científicos, "disse Prabhat." Mais geralmente, nosso projeto lançou as bases para o aprendizado profundo exascale para a ciência, bem como aplicações comerciais. "