Os neurocientistas treinam uma rede neural profunda para processar sons como os humanos fazem

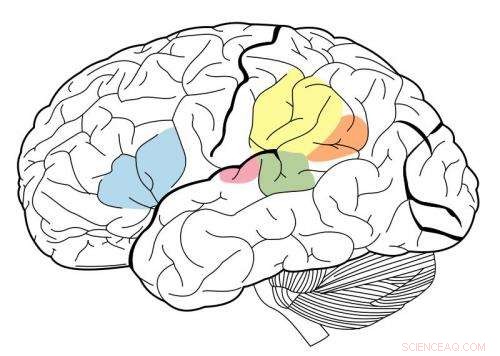

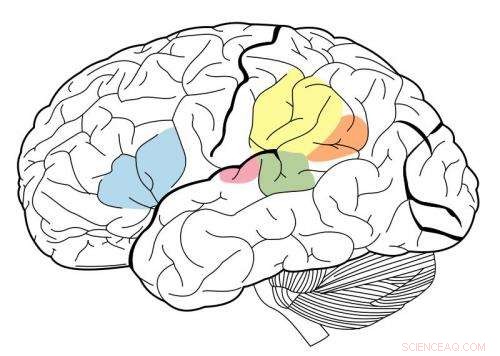

p O córtex auditivo primário é destacado em magenta, e é conhecido por interagir com todas as áreas destacadas neste mapa neural. Crédito:Wikipedia.

p O córtex auditivo primário é destacado em magenta, e é conhecido por interagir com todas as áreas destacadas neste mapa neural. Crédito:Wikipedia.

p Usando um sistema de aprendizado de máquina conhecido como rede neural profunda, Os pesquisadores do MIT criaram o primeiro modelo que pode replicar o desempenho humano em tarefas auditivas, como a identificação de um gênero musical. p Este modelo, que consiste em muitas camadas de unidades de processamento de informações que podem ser treinadas em grandes volumes de dados para realizar tarefas específicas, foi usado pelos pesquisadores para esclarecer como o cérebro humano pode estar executando as mesmas tarefas.

p "O que esses modelos nos oferecem, pela primeira vez, são sistemas de máquina que podem realizar tarefas sensoriais que são importantes para os humanos e que o fazem em níveis humanos, "diz Josh McDermott, Frederick A. e Carole J. Middleton Professor Assistente de Neurociência no Departamento de Cérebro e Ciências Cognitivas do MIT e o autor sênior do estudo. "Historicamente, este tipo de processamento sensorial tem sido difícil de entender, em parte porque não temos realmente uma base teórica muito clara e uma boa maneira de desenvolver modelos do que pode estar acontecendo. "

p O estudo, que aparece na edição de 19 de abril da

Neurônio , também oferece evidências de que o córtex auditivo humano está organizado em uma organização hierárquica, muito parecido com o córtex visual. Neste tipo de arranjo, a informação sensorial passa por sucessivos estágios de processamento, com informações básicas processadas anteriormente e recursos mais avançados, como o significado da palavra extraído em estágios posteriores.

p O estudante de graduação do MIT Alexander Kell e o professor assistente da Universidade de Stanford Daniel Yamins são os principais autores do artigo. Outros autores são a ex-estudante visitante do MIT Erica Shook e o ex-pós-doutorado do MIT Sam Norman-Haignere.

p

Modelando o cérebro

p Quando as redes neurais profundas foram desenvolvidas pela primeira vez na década de 1980, os neurocientistas esperavam que tais sistemas pudessem ser usados para modelar o cérebro humano. Contudo, os computadores daquela época não eram poderosos o suficiente para construir modelos grandes o suficiente para realizar tarefas do mundo real, como reconhecimento de objetos ou reconhecimento de fala.

p Nos últimos cinco anos, avanços na capacidade de computação e tecnologia de rede neural tornaram possível o uso de redes neurais para realizar tarefas difíceis do mundo real, e eles se tornaram a abordagem padrão em muitas aplicações de engenharia. Em paralelo, alguns neurocientistas revisitaram a possibilidade de que esses sistemas possam ser usados para modelar o cérebro humano.

p "Essa tem sido uma oportunidade empolgante para a neurociência, em que podemos realmente criar sistemas que podem fazer algumas das coisas que as pessoas podem fazer, e podemos interrogar os modelos e compará-los ao cérebro, "Kell diz.

p Os pesquisadores do MIT treinaram sua rede neural para realizar duas tarefas auditivas, um envolvendo fala e outro envolvendo música. Para a tarefa de fala, os pesquisadores deram ao modelo milhares de gravações de dois segundos de uma pessoa falando. A tarefa era identificar a palavra no meio do clipe. Para a tarefa de música, a modelo foi solicitada a identificar o gênero de um clipe de música de dois segundos. Cada clipe também incluía ruído de fundo para tornar a tarefa mais realista (e mais difícil).

p Depois de muitos milhares de exemplos, o modelo aprendeu a executar a tarefa com a mesma precisão de um ouvinte humano.

p "A ideia é que, com o tempo, o modelo fica cada vez melhor na tarefa, "Kell diz." A esperança é que ele esteja aprendendo algo geral, então, se você apresentar um novo som que o modelo nunca ouviu antes, vai fazer bem, e, na prática, muitas vezes é o caso. "

p O modelo também tendia a cometer erros nos mesmos clipes em que os humanos cometiam mais erros.

p As unidades de processamento que compõem uma rede neural podem ser combinadas de várias maneiras, formando diferentes arquiteturas que afetam o desempenho do modelo.

p A equipe do MIT descobriu que o melhor modelo para essas duas tarefas era aquele que dividia o processamento em dois conjuntos de estágios. O primeiro conjunto de etapas foi compartilhado entre as tarefas, mas depois disso, ele se dividiu em dois ramos para análise posterior - um ramo para a tarefa de fala, e um para a tarefa de gênero musical.

p

Evidência para hierarquia

p Os pesquisadores então usaram seu modelo para explorar uma questão de longa data sobre a estrutura do córtex auditivo:se ele é organizado hierarquicamente.

p Em um sistema hierárquico, uma série de regiões cerebrais realiza diferentes tipos de computação nas informações sensoriais à medida que elas fluem pelo sistema. Está bem documentado que o córtex visual tem esse tipo de organização. Regiões anteriores, conhecido como córtex visual primário, responder a recursos simples, como cor ou orientação. Os estágios posteriores permitem tarefas mais complexas, como reconhecimento de objetos.

p Contudo, tem sido difícil testar se este tipo de organização também existe no córtex auditivo, em parte porque não existem bons modelos que possam replicar o comportamento auditivo humano.

p "Pensamos que se pudéssemos construir um modelo que pudesse fazer algumas das mesmas coisas que as pessoas fazem, podemos, então, ser capazes de comparar diferentes estágios do modelo a diferentes partes do cérebro e obter algumas evidências de se essas partes do cérebro podem ser organizadas hierarquicamente, "McDermott diz.

p Os pesquisadores descobriram que em seu modelo, características básicas do som, como frequência, são mais fáceis de extrair nos estágios iniciais. À medida que as informações são processadas e avançam ao longo da rede, torna-se mais difícil extrair a frequência, mas é mais fácil extrair informações de nível superior, como palavras.

p Para ver se os estágios do modelo podem replicar como o córtex auditivo humano processa informações de som, os pesquisadores usaram imagens de ressonância magnética funcional (fMRI) para medir diferentes regiões do córtex auditivo enquanto o cérebro processa sons do mundo real. Eles então compararam as respostas do cérebro às respostas no modelo quando ele processou os mesmos sons.

p Eles descobriram que os estágios intermediários do modelo corresponderam melhor à atividade no córtex auditivo primário, e os estágios posteriores corresponderam melhor à atividade fora do córtex primário. Isso fornece evidências de que o córtex auditivo pode ser organizado de forma hierárquica, semelhante ao córtex visual, dizem os pesquisadores.

p "O que vemos muito claramente é uma distinção entre o córtex auditivo primário e tudo o mais, "McDermott diz.

p Os autores agora planejam desenvolver modelos que podem realizar outros tipos de tarefas auditivas, como determinar o local de onde veio um determinado som, para explorar se essas tarefas podem ser feitas pelos caminhos identificados neste modelo ou se eles exigem caminhos separados, que poderia então ser investigada no cérebro.