Os filamentos propostos de matéria escura em torno de Júpiter podem fazer parte dos misteriosos 95 por cento da massa-energia do universo. Crédito:NASA / JPL-Caltech

A maior parte do universo é escuro, com matéria escura e energia escura compreendendo mais de 95 por cento de sua massa-energia. No entanto, sabemos pouco sobre matéria escura e energia. Para encontrar respostas, cientistas realizam enormes experimentos de física de alta energia. A análise dos resultados exige computação de alto desempenho - às vezes equilibrada com tendências industriais.

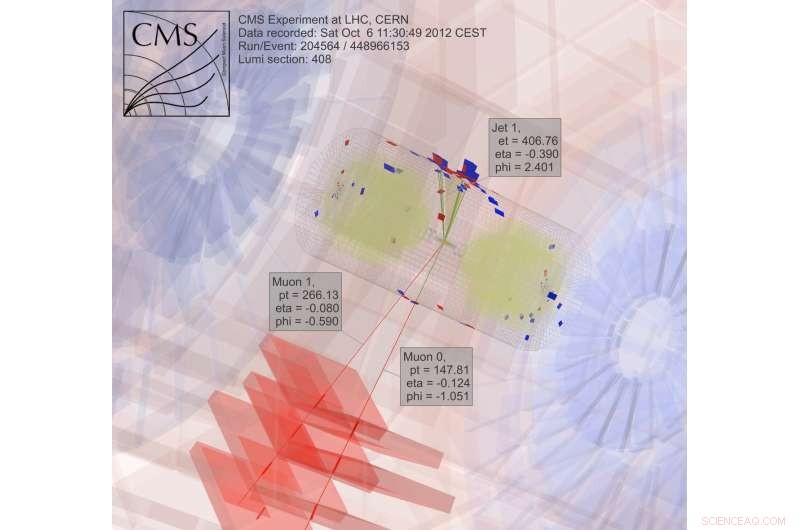

Após quatro anos executando computação para o experimento Large Hadron Collider CMS no CERN perto de Genebra, Suíça - parte do trabalho que revelou o bóson de Higgs - Oliver Gutsche, um cientista do Laboratório Nacional do Acelerador Fermi do Departamento de Energia (DOE), voltou-se para a busca de matéria escura. "O bóson de Higgs foi previsto, e sabíamos aproximadamente onde procurar, "ele diz." Com a matéria escura, não sabemos o que estamos procurando. "

Para aprender sobre a matéria escura, Gutsche precisa de mais dados. Assim que essa informação estiver disponível, os físicos devem explorá-lo. Eles estão explorando ferramentas computacionais para o trabalho, incluindo o software de código aberto Apache Spark.

Em busca de matéria escura, os físicos estudam os resultados da colisão de partículas. "Isso é trivial para paralelizar, "dividir o trabalho em pedaços para obter respostas mais rapidamente, Gutsche explica. "Dois PCs podem cada um processar uma colisão, "o que significa que os pesquisadores podem empregar uma grade de computador para analisar os dados.

Muito do trabalho em física de alta energia, no entanto, depende do software que os cientistas desenvolvem. "Se nossos alunos de graduação e pós-doutorados conhecerem apenas nossas ferramentas proprietárias, então eles terão problemas se forem para a indústria, "onde tal software não estiver disponível, Notas de Gutsche. "Então comecei a pesquisar o Spark."

Spark é uma ferramenta de redução de dados feita para arquivos de texto não estruturados. Isso cria um desafio - acessar os dados da física de alta energia, que estão em um formato orientado a objetos. Os pesquisadores de ciência da computação do Fermilab, Saba Sehrish e Jim Kowalkowski, estão lidando com a tarefa.

Spark ofereceu promessa desde o início, com alguns recursos particularmente interessantes, Sehrish diz. "Um estava na memória, processamento distribuído em grande escala "por meio de interfaces de alto nível, o que o torna fácil de usar. "Você não quer que os cientistas se preocupem em como distribuir dados e escrever código paralelo, "diz ela. Spark cuida disso.

Outro recurso atraente:Spark é uma plataforma de pesquisa com suporte no National Energy Research Scientific Computing Center (NERSC), uma instalação de usuário do DOE Office of Science no Lawrence Berkeley National Laboratory do DOE. "Isso nos dá uma equipe de suporte que pode ajustá-lo, "Kowalkowski diz. Cientistas da computação como Sehrish e Kowalkowski podem adicionar recursos, mas fazer com que o código subjacente funcione da forma mais eficiente possível requer especialistas do Spark, alguns dos quais trabalham no NERSC.

Kowalkowski resume os recursos desejáveis do Spark como "dimensionamento automatizado, paralelismo automatizado e um modelo de programação razoável. "

Resumidamente, ele e Sehrish querem construir um sistema que permita aos pesquisadores executar uma análise que execute extremamente bem em máquinas de grande escala, sem complicações e por meio de uma interface de usuário fácil.

Para procurar matéria escura, cientistas coletam e analisam resultados de partículas em colisão, um processo extremamente intenso computacionalmente. Crédito:CMS CERN

Por ser fácil de usar, no entanto, não é suficiente ao lidar com dados da física de alta energia. O Spark parece satisfazer as metas de facilidade de uso e desempenho até certo ponto. Os pesquisadores ainda estão investigando alguns aspectos de seu desempenho para aplicações de física de alta energia, mas os cientistas da computação não podem ter tudo. "Existe um compromisso, "Afirma Sehrish." Quando você está procurando mais desempenho, você não consegue facilidade de uso. "

Os cientistas do Fermilab selecionaram o Spark como uma escolha inicial para explorar a ciência de big data, e a matéria escura é apenas a primeira aplicação em teste. "Precisamos de vários casos de uso real para entender a viabilidade de usar o Spark para uma tarefa de análise, "Sehrish diz. Com cientistas como Gutsche do Fermilab, a matéria escura era um bom lugar para começar. Sehrish e Kowalkowski querem simplificar a vida dos cientistas que fazem a análise. "Trabalhamos com cientistas para entender seus dados e trabalhar com suas análises, "Sehrish diz." Então, podemos ajudá-los a organizar melhor os conjuntos de dados, organizar melhor as tarefas de análise. "

Como primeira etapa desse processo, Sehrish e Kowalkowski devem obter dados de experimentos de física de alta energia para o Spark. Notas Kowalkowski, "Você tem petabytes de dados em formatos experimentais específicos que devem ser transformados em algo útil para outra plataforma."

Os dados iniciais para a implementação de matéria escura são formatados para plataformas de computação de alto rendimento, mas o Spark não lida com essa configuração. Portanto, o software deve ler o formato de dados original e convertê-lo em algo que funcione bem com o Spark.

Ao fazer isso, Sehrish explica, "você deve considerar cada decisão em cada etapa, porque como você estrutura os dados, como você lê na memória e projeta e implementa operações para alto desempenho está tudo vinculado. "

Cada uma dessas etapas de tratamento de dados afeta o desempenho do Spark. Embora seja muito cedo para dizer quanto desempenho pode ser obtido do Spark ao analisar dados de matéria escura, Sehrish e Kowalkowski veem que o Spark pode fornecer um código amigável que permite aos pesquisadores de física de alta energia iniciar um trabalho em centenas de milhares de núcleos. "Spark é bom nesse aspecto, "Sehrish diz." Também vimos um bom dimensionamento - não desperdiçando recursos de computação à medida que aumentamos o tamanho do conjunto de dados e o número de nós. "

Ninguém sabe se essa será uma abordagem viável até determinar o desempenho máximo do Spark para esses aplicativos. "A chave principal, "Kowalkowski diz, "é que ainda não estamos convencidos de que essa é a tecnologia para avançar."

Na verdade, A própria faísca muda. Seu uso extensivo de código aberto cria um ciclo de desenvolvimento constante e rápido. Portanto, Sehrish e Kowalkowski devem manter seu código atualizado com os novos recursos do Spark.

“O ciclo constante de crescimento com Spark é o custo de trabalhar com tecnologia de ponta e algo com muitos interesses de desenvolvimento, "Sehrish diz.

Pode levar alguns anos até que Sehrish e Kowalkowski tomem uma decisão sobre o Spark. A conversão de software criado para computação de alto rendimento em ferramentas de computação de alto desempenho e fáceis de usar requer um ajuste fino e trabalho em equipe entre cientistas experimentais e computacionais. Ou, pode-se dizer, é preciso mais do que um tiro no escuro.