Como robôs, carros autônomos e outras máquinas inteligentes introduzem a IA na vida cotidiana, uma nova maneira de projetar algoritmos pode ajudar os desenvolvedores de aprendizado de máquina a criar proteções contra resultados indesejáveis, como preconceito racial e de gênero. Crédito:Deboki Chakravarti

A inteligência artificial entrou no mercado comercial graças à habilidade crescente dos algoritmos de aprendizado de máquina que permitem que os computadores se treinem para fazer coisas como dirigir carros, controlar robôs ou automatizar a tomada de decisões.

Mas, à medida que a IA começa a lidar com tarefas sensíveis, como ajudar a escolher quais prisioneiros receberão fiança, os formuladores de políticas estão insistindo que os cientistas da computação ofereçam garantias de que os sistemas automatizados foram projetados para minimizar, se não evitar completamente, resultados indesejados, como risco excessivo ou preconceito racial e de gênero.

Uma equipe liderada por pesquisadores de Stanford e da Universidade de Massachusetts Amherst publicou um artigo em 22 de novembro em Ciência sugerindo como fornecer tais garantias. O artigo descreve uma nova técnica que traduz uma meta difusa, como evitar preconceitos de gênero, nos critérios matemáticos precisos que permitiriam a um algoritmo de aprendizado de máquina treinar um aplicativo de IA para evitar esse comportamento.

"Queremos desenvolver a IA que respeite os valores de seus usuários humanos e justifique a confiança que depositamos em sistemas autônomos, "disse Emma Brunskill, professor assistente de ciência da computação em Stanford e autor sênior do artigo.

Evitando mau comportamento

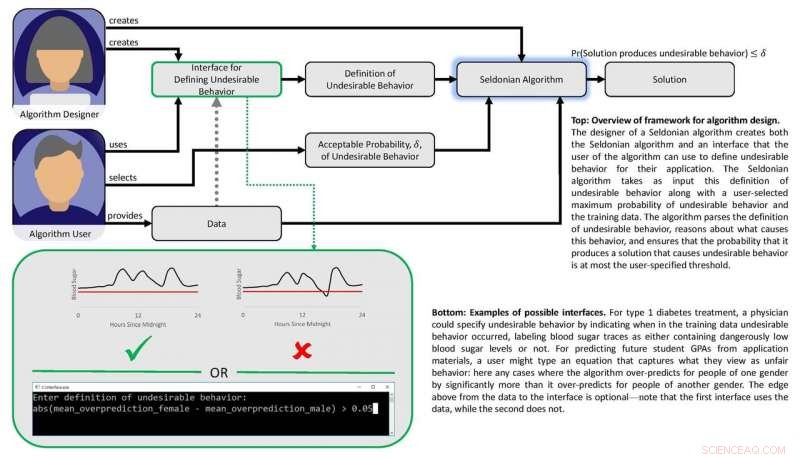

O trabalho tem como premissa a noção de que, se resultados ou comportamentos "inseguros" ou "injustos" podem ser definidos matematicamente, então, deve ser possível criar algoritmos que podem aprender com os dados sobre como evitar esses resultados indesejados com alta confiança. Os pesquisadores também queriam desenvolver um conjunto de técnicas que tornassem mais fácil para os usuários especificarem quais tipos de comportamento indesejado eles desejam restringir e permitir que os designers de aprendizado de máquina prevejam com confiança que um sistema treinado com dados anteriores pode ser confiável quando é aplicado em circunstâncias do mundo real.

"Mostramos como os designers de algoritmos de aprendizado de máquina podem tornar mais fácil para as pessoas que desejam incorporar IA em seus produtos e serviços para descrever resultados ou comportamentos indesejados que o sistema de IA evitará com alta probabilidade, "disse Philip Thomas, professor assistente de ciência da computação na Universidade de Massachusetts Amherst e primeiro autor do artigo.

Justiça e segurança

Os pesquisadores testaram sua abordagem tentando melhorar a justiça dos algoritmos que prevêem GPAs de estudantes universitários com base nos resultados dos exames, uma prática comum que pode resultar em preconceito de gênero. Usando um conjunto de dados experimental, eles deram ao algoritmo instruções matemáticas para evitar o desenvolvimento de um método preditivo que sistematicamente superestimou ou subestimou os GPAs para um gênero. Com essas instruções, o algoritmo identificou uma maneira melhor de prever os GPAs dos alunos com muito menos viés de gênero sistemático do que os métodos existentes. Os métodos anteriores tinham dificuldades a esse respeito porque não tinham um filtro de imparcialidade integrado ou porque os algoritmos desenvolvidos para atingir a imparcialidade eram muito limitados em escopo.

O grupo desenvolveu outro algoritmo e o usou para equilibrar segurança e desempenho em uma bomba de insulina automática. Essas bombas devem decidir o quão grande ou pequena a dose de insulina a ser administrada a um paciente na hora das refeições. Idealmente, a bomba fornece insulina suficiente para manter os níveis de açúcar no sangue estáveis. Pouca insulina permite que os níveis de açúcar no sangue aumentem, levando a desconfortos de curto prazo, como náuseas, e risco elevado de complicações a longo prazo, incluindo doenças cardiovasculares. Demais e o açúcar no sangue cai - um resultado potencialmente mortal.

Diagrama representando a estrutura do papel. Crédito:Philip Thomas

O aprendizado de máquina pode ajudar identificando padrões sutis nas respostas de açúcar no sangue de um indivíduo às doses, mas os métodos existentes não tornam mais fácil para os médicos especificarem os resultados que os algoritmos de dosagem automatizada devem evitar, como quedas de açúcar no sangue. Usando um simulador de glicose no sangue, Brunskill e Thomas mostraram como as bombas poderiam ser treinadas para identificar a dosagem sob medida para aquela pessoa - evitando complicações de dosagem excessiva ou insuficiente. Embora o grupo não esteja pronto para testar este algoritmo em pessoas reais, ele aponta para uma abordagem de IA que pode, eventualmente, melhorar a qualidade de vida dos diabéticos.

Em seus Ciência papel, Brunskill e Thomas usam o termo "algoritmo Seldoniano" para definir sua abordagem, uma referência a Hari Seldon, um personagem inventado pelo autor de ficção científica Isaac Asimov, que uma vez proclamou três leis da robótica, começando com a injunção de que "Um robô não pode ferir um ser humano ou, por meio da inação, permitir que um ser humano sofra algum dano. "

Embora reconheça que o campo ainda está longe de garantir as três leis, Thomas disse que esta estrutura Seldoniana tornará mais fácil para os designers de aprendizado de máquina construir instruções de evitação de comportamento em todos os tipos de algoritmos, de uma forma que pode permitir que eles avaliem a probabilidade de que os sistemas treinados funcionem adequadamente no mundo real.

Brunskill disse que a estrutura proposta se baseia nos esforços que muitos cientistas da computação estão fazendo para encontrar um equilíbrio entre a criação de algoritmos poderosos e o desenvolvimento de métodos para garantir sua confiabilidade.

"Pensar em como podemos criar algoritmos que melhor respeitem valores como segurança e justiça é essencial, pois a sociedade depende cada vez mais da IA, "Brunskill disse.