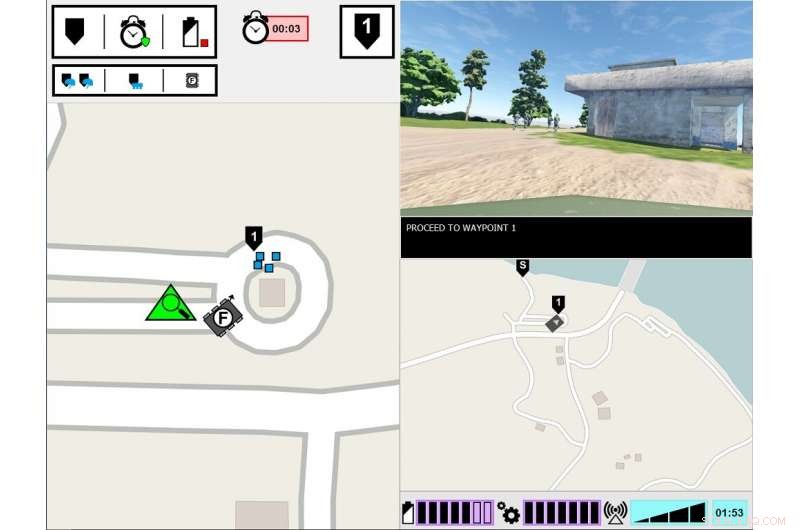

Interface experimental ASM. O monitor do lado esquerdo exibe o ponto de vista do soldado líder do ambiente da tarefa. O monitor do lado direito exibe a interface de comunicação do ASM. Crédito:Exército dos EUA

O que é preciso para um humano confiar em um robô? Isso é o que pesquisadores do Exército estão descobrindo em um novo estudo sobre como humanos e robôs trabalham juntos.

Pesquisa em equipe de agente humano, ou HAT, examinou como a transparência dos agentes, como robôs, veículos não tripulados ou agentes de software - influencia a confiança humana, desempenho da tarefa, carga de trabalho e percepções do agente. A transparência do agente refere-se à sua capacidade de transmitir aos humanos sua intenção, processo de raciocínio e planos futuros.

Uma nova pesquisa liderada pelo Exército descobriu que a confiança humana nos robôs diminui depois que o robô comete um erro, mesmo quando é transparente com seu processo de raciocínio. O papel, "Transparência e confiabilidade do agente na interação homem-robô:a influência na confiança do usuário e na confiabilidade percebida, "foi publicado na edição de agosto da IEEE-Transações em Sistemas Homem-Máquina .

A data, a pesquisa se concentrou amplamente no HAT com agentes inteligentes perfeitamente confiáveis - o que significa que os agentes não cometem erros - mas este é um dos poucos estudos que explorou como a transparência do agente interage com a confiabilidade do agente. Neste último estudo, humanos testemunharam um robô cometendo um erro, e os pesquisadores se concentraram em saber se os humanos percebiam o robô como menos confiável, mesmo quando o humano foi informado sobre o processo de raciocínio do robô.

"Compreender como o comportamento do robô influencia seus companheiros humanos é crucial para o desenvolvimento de equipes humanos-robôs eficazes, bem como o design de interfaces e métodos de comunicação entre os membros da equipe, "disse a Dra. Julia Wright, investigador principal deste projeto e pesquisador do Laboratório de Pesquisa do Exército do Comando de Desenvolvimento de Capacidades de Combate do Exército dos EUA, também conhecido como ARL. "Esta pesquisa contribui para os esforços de Operações Multi-Domínio do Exército para garantir a superação das capacidades habilitadas pela inteligência artificial. Mas também é interdisciplinar, já que suas descobertas informarão o trabalho de psicólogos, roboticistas, engenheiros, e designers de sistema que estão trabalhando para facilitar um melhor entendimento entre humanos e agentes autônomos no esforço de fazer companheiros de equipe autônomos em vez de simplesmente ferramentas.

Esta pesquisa foi um esforço conjunto entre a ARL e o Instituto de Simulações e Treinamento da Universidade da Flórida Central, e é o terceiro e último estudo do projeto Autonomous Squad Member (ASM), patrocinado pela Iniciativa Piloto de Pesquisa em Autonomia do Gabinete do Secretário de Defesa. O ASM é um pequeno robô terrestre que interage e se comunica com um esquadrão de infantaria.

Estudos anteriores do ASM investigaram como um robô se comunicaria com um colega de equipe humano. Usando o modelo de Transparência do Agente baseado em consciência da situação como um guia, vários métodos de visualização para transmitir os objetivos do agente, intenções, raciocínio, restrições, e os resultados projetados foram explorados e testados. Um módulo iconográfico rápido foi desenvolvido com base nessas descobertas do estudo inicial, e então foi usado em estudos subsequentes para explorar a eficácia da transparência do agente na HAT.

Os pesquisadores conduziram este estudo em um ambiente simulado, em que os participantes observaram uma equipe de soldado agente humano, que incluiu o ASM, atravessando um curso de treinamento. A tarefa dos participantes era monitorar a equipe e avaliar o robô. A equipe Soldado-robô encontrou vários eventos ao longo do curso e respondeu de acordo. Embora os soldados sempre respondam corretamente ao evento, ocasionalmente, o robô entendeu mal a situação, levando a ações incorretas. A quantidade de informações que o robô compartilhou variou entre as tentativas. Embora o robô sempre explique suas ações, as razões por trás de suas ações e o resultado esperado de suas ações, em alguns testes, o robô também compartilhou o raciocínio por trás de suas decisões, sua lógica subjacente. Os participantes viram várias equipes de robô-soldado, e suas avaliações dos robôs foram comparadas.

O estudo descobriu que, independentemente da transparência do robô em explicar seu raciocínio, a confiabilidade do robô foi o fator determinante final para influenciar as projeções dos participantes da confiabilidade futura do robô, confiança no robô e percepções do robô. Isso é, depois que os participantes testemunharam um erro, eles continuaram a avaliar a confiabilidade do robô mais baixa, mesmo quando o robô não cometeu nenhum erro subsequente. Embora essas avaliações tenham melhorado lentamente ao longo do tempo, desde que o robô não cometesse mais erros, a confiança dos participantes em suas próprias avaliações da confiabilidade do robô permaneceu reduzida durante o restante dos testes, quando comparado com participantes que nunca viram um erro. Além disso, os participantes que testemunharam um erro do robô relataram baixa confiança no robô, quando comparado com aqueles que nunca testemunharam um erro de robô.

O aumento da transparência do agente foi encontrado para melhorar a confiança dos participantes no robô, mas apenas quando o robô estava coletando ou filtrando informações. Isso pode indicar que o compartilhamento de informações detalhadas pode mitigar alguns dos efeitos da automação não confiável para tarefas específicas, Disse Wright. Adicionalmente, participantes avaliaram o robô não confiável como menos animado, simpático, inteligente, e seguro do que o robô confiável.

"Estudos anteriores sugerem que o contexto é importante para determinar a utilidade das informações de transparência, "Wright disse." Precisamos entender melhor quais tarefas exigem uma compreensão mais aprofundada do raciocínio do agente, e como discernir o que essa profundidade implicaria. Pesquisas futuras devem explorar maneiras de fornecer informações de transparência com base nos requisitos de tarefas. "