Crédito:openai

Os pesquisadores fizeram notícia ao permitir que suas ambições de IA jogassem um jogo formidável de esconde-esconde com resultados formidáveis. O ambiente dos agentes contava com paredes e caixas móveis para um desafio onde uns eram os escondidos e outros, buscadores. Muito aconteceu ao longo do caminho, com surpresas.

Declarando o que foi aprendido, os autores blogaram:"Observamos agentes descobrindo o uso de ferramentas cada vez mais complexas enquanto jogavam um jogo simples de esconde-esconde, "onde os agentes construíram" uma série de seis estratégias e contraestratégias distintas, alguns dos quais não sabíamos que nosso ambiente era compatível. "

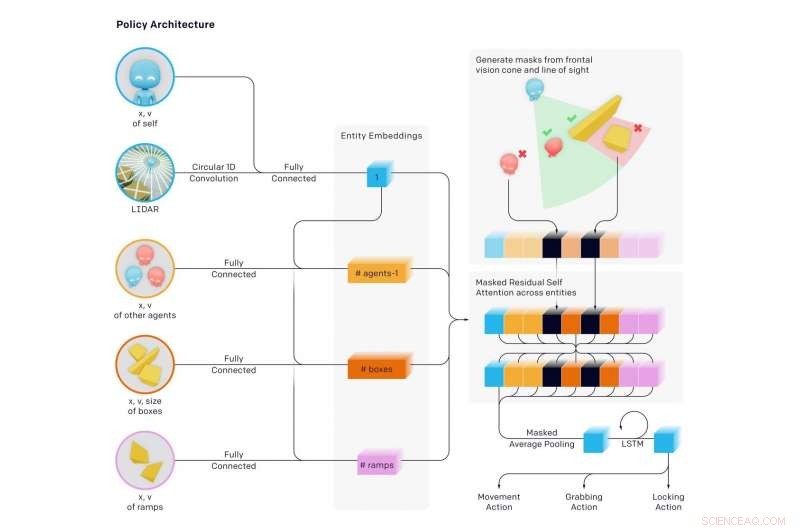

Em um novo artigo lançado no início desta semana, a equipe revelou resultados. Seu papel, "Uso de ferramenta emergente de autocurricula multiagente, "teve sete autores, seis dos quais tinham representação OpenAI listada, e um, Google Brain.

Os autores comentaram sobre o tipo de desafio que estavam enfrentando. "Criar agentes artificiais inteligentes que podem resolver uma ampla variedade de tarefas complexas relevantes para o ser humano tem sido um desafio de longa data na comunidade de inteligência artificial."

A equipe disse que "descobrimos que os agentes criam um autocurriculum auto-supervisionado, induzindo várias rodadas distintas de estratégia emergente, muitos dos quais requerem coordenação e uso de ferramentas sofisticadas. "

Por meio de esconde-esconde, (1) Os Seekers aprenderam a perseguir os Hiders e os Hiders aprenderam a fugir (2) Os Hiders aprenderam a usar ferramentas básicas - caixas e paredes para construir fortes. (3) Os buscadores aprenderam a usar rampas para pular para o abrigo dos escondidos (4) Os escondidos aprenderam a mover as rampas para longe de onde construirão seu forte, e trancá-los no lugar (5) Os Seekers aprenderam que podem pular de rampas trancadas para caixas e surfar na caixa para o abrigo dos escondidos e (6) Os Hiders aprenderam a trancar as caixas não utilizadas antes de construir seu forte.

Essas seis estratégias surgiram como agentes treinados uns contra os outros no esconde-esconde - cada nova estratégia criou uma pressão anteriormente inexistente para os agentes progredirem para o próximo estágio, sem quaisquer incentivos diretos para os agentes interagirem com objetos ou explorarem. As estratégias foram resultado do "autocurriculum" induzido pela competição multiagente e pela dinâmica do esconde-esconde.

Os autores do blog disseram que aprenderam "é muito comum que os agentes encontrem uma maneira de explorar o ambiente que você constrói ou o mecanismo de física de uma maneira não intencional".

O que estava acontecendo era uma "complexidade emergente auto-supervisionada". E isso "sugere ainda que a co-adaptação multiagente pode um dia produzir um comportamento extremamente complexo e inteligente". Os autores afirmaram de forma semelhante em seu artigo que "induzir autocurricula em ambientes abertos e fisicamente aterrados poderia, eventualmente, permitir que os agentes adquirissem um número ilimitado de habilidades relevantes para o ser humano."

Douglas Heaven, New Scientist , realmente despertou o interesse dos leitores pela maneira como descreveu o que aconteceu:

"Inicialmente, os hiders simplesmente fugiram. Mas, eles logo descobriram que a maneira mais rápida de confundir os buscadores era encontrar objetos no ambiente para se esconderem da vista, usando-os como uma espécie de ferramenta. Por exemplo, aprenderam que as caixas podem ser usadas para bloquear portas e construir esconderijos simples. Os buscadores aprenderam que podiam mover uma rampa e usá-la para escalar paredes. Os bots então descobriram que ser um jogador de equipe - passando objetos uns para os outros ou colaborando em um esconderijo - era a maneira mais rápida de vencer. "

Este foi um projeto ambicioso. Examinando seu trabalho, MIT Technology Review observou que a IA aprendeu a usar ferramentas após quase 500 milhões de jogos de esconde-esconde. Jogando esconde-esconde centenas de milhões de rodadas, duas equipes opostas de agentes de IA desenvolveram estratégias complexas de ocultação e busca.

Karen Hao apresentou um marcador interessante do que os agentes aprenderam após quantas rodadas:"... em torno da marca de 25 milhões de jogos, a brincadeira tornou-se mais sofisticada. Os escondedores aprenderam a mover e trancar as caixas e barricadas no ambiente para construir fortes ao redor deles, para que os buscadores nunca os vissem. "

Mais milhões de rodadas:os buscadores descobriram uma contra-estratégia, enquanto eles aprenderam a mover uma rampa próxima ao forte dos hiders e usá-la para escalar as paredes. Mais rodadas depois, os escondedores aprenderam a travar as rampas antes de construir seu forte.

Ainda mais estratégias surgiram na marca de 380 milhões de jogos. surgiram mais duas estratégias. Os buscadores desenvolveram uma estratégia para invadir o forte dos hiders usando uma rampa trancada para subir em uma caixa destrancada, em seguida, "surfe" no topo da caixa até o forte e por cima de suas paredes. Na fase final, os escondedores mais uma vez aprenderam a trancar todas as rampas e caixas no lugar antes de construir seu forte.

Hao citou Bowen Baker, um dos autores do artigo. "Não dissemos aos hiders ou seekers para correrem perto de uma caixa ou interagirem com ela ... Mas através da competição multiagente, eles criaram novas tarefas um para o outro, de modo que a outra equipe teve que se adaptar. "

Pense sobre isso. Baker disse que eles não contaram aos escondidos, e eles não disseram aos buscadores, correr perto de caixas nem interagir com elas.

Devin Coldewey em TechCrunch pensei sobre isso. "O estudo pretendia, e investiguei com sucesso a possibilidade de agentes de aprendizado de máquina sofisticados, técnicas relevantes do mundo real, sem qualquer interferência de sugestões dos pesquisadores. "

Coldewey acertou em cheio por todo esse trabalho. "Como explicam os autores do artigo, foi assim que surgimos. "

Nós, como em seres humanos. Coldewey citou uma passagem de seu jornal.

"A vasta quantidade de complexidade e diversidade na Terra evoluiu devido à coevolução e competição entre organismos, dirigido pela seleção natural. Quando uma nova estratégia ou mutação de sucesso surge, ele muda a distribuição implícita de tarefas que os agentes vizinhos precisam resolver e cria uma nova pressão para adaptação. Essas corridas armamentistas evolucionárias criam autocurricula implícita, por meio dos quais os agentes concorrentes criam continuamente novas tarefas uns para os outros. "

© 2019 Science X Network