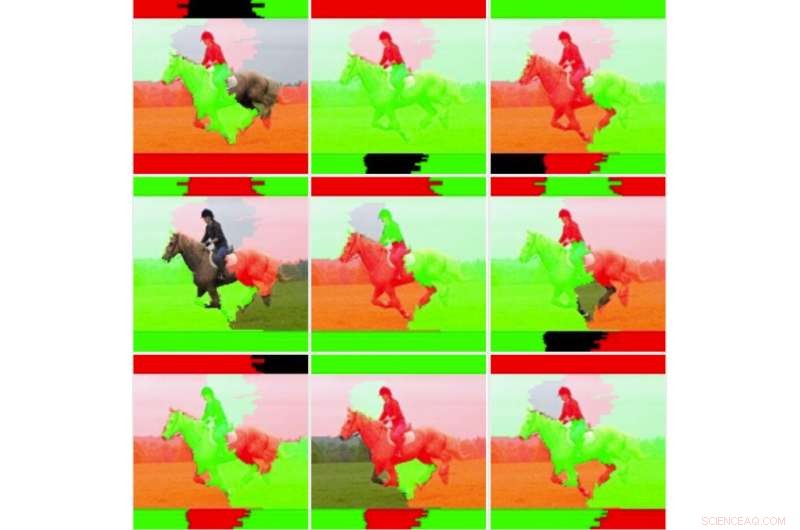

A imagem de entrada original. Crédito:Lee et al.

Pesquisadores da IBM Research UK, a Academia Militar dos EUA e a Universidade de Cardiff propuseram recentemente uma nova abordagem para melhorar a sensibilidade de LIME (Explicações Agnósticas de Modelo Interpretável Local), uma técnica para obter um melhor entendimento das conclusões alcançadas por algoritmos de aprendizado de máquina. Seu papel, publicado na biblioteca digital SPIE, poderia informar o desenvolvimento de ferramentas de inteligência artificial (IA) que fornecem explicações exaustivas de como chegaram a um determinado resultado ou conclusão.

"Acreditamos que a IA e o aprendizado de máquina podem apoiar e aumentar a tomada de decisão humana, mas que também existe a necessidade de uma IA explicável, "Eunjin Lee, co-autor do artigo de pesquisa original e Especialista em Tecnologia Emergente e Inventor Sênior na IBM Research U.K., disse TechXplore. "Hoje, as decisões tomadas por muitos sistemas de aprendizado de máquina são inexplicáveis, ou seja, não há como nós, humanos, sabermos como os sistemas chegaram a essas decisões. Nossa pesquisa aborda esse problema investigando como melhorar as técnicas de explicabilidade que visam lançar luz sobre a natureza da 'caixa preta' dos processos de aprendizado de máquina. "

LIME é uma técnica de explicabilidade particularmente popular que pode ser aplicada a muitos modelos de aprendizado de máquina. Apesar de sua versatilidade, muitas vezes é visto como não confiável e, portanto, ineficaz no fornecimento de explicações, também pela variabilidade dos resultados que produz. Em vez de desenvolver uma técnica de explicabilidade inteiramente nova, Lee e seus colegas decidiram identificar mecanismos que pudessem aprimorar as explicações de LIME.

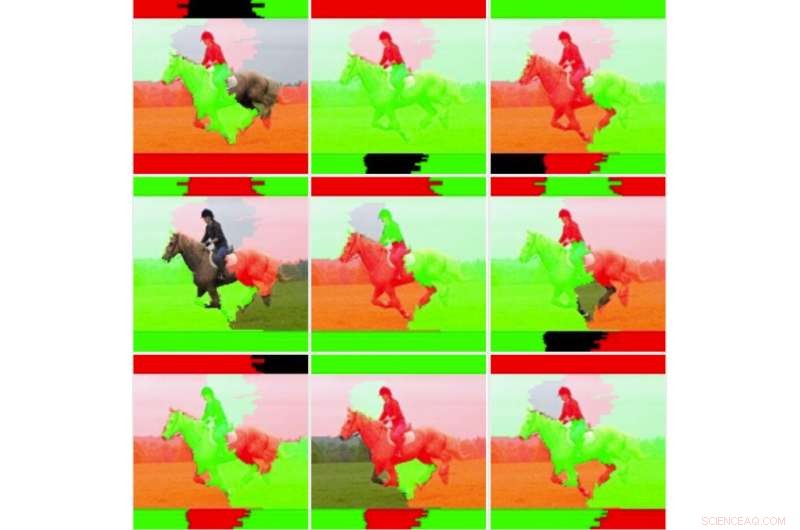

"Queríamos primeiro analisar mais profundamente a instabilidade que outros pesquisadores observaram para determinar se LIME era realmente instável, "Lee explicou." Para fazer isso, testamos o LIME em relação ao nosso conjunto de dados e modelo de aprendizado de máquina sem alterar o código subjacente. Imediatamente descobrimos que as imagens explicativas resultantes variavam consideravelmente e não pareciam consistentes. Este é talvez o ponto em que muitos simplesmente parariam de usar a técnica. "

Nove saídas de imagem para a técnica LIME não modificada. Crédito:Lee et al.

Quando Lee e seus colegas se aprofundaram nas estatísticas subjacentes do LIME, eles descobriram que embora as imagens geradas parecessem "visualmente instáveis, "a explicação padrão não levou em consideração todas as informações estatísticas. Por exemplo, a coloração das imagens explicativas era muito simples e não considerava todos os dados subjacentes (por exemplo, não contabilizou técnicas como sombreamento ou transparência). Esta descoberta explica em parte porque as explicações geradas pelo LIME às vezes falham em transmitir a certeza da classificação para os usuários humanos.

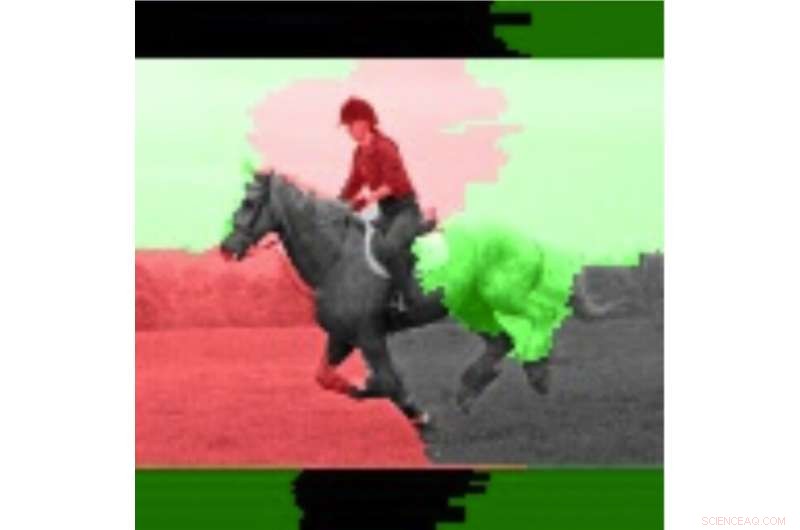

"Geralmente é o caso de sistemas dinâmicos, como os que examinamos neste estudo, que executar vários testes e investigar os valores médios pode ser benéfico, "Disse Lee." Ao adotar essa abordagem, percebemos que a estabilidade das explicações melhorou ao considerar os valores médios e os desvios padrão em várias execuções, em vez de apenas executar a explicação uma vez. "

Em seu estudo, Lee e seus colegas treinaram um modelo de rede neural convolucional (CNN) usando duas classes de imagens, a saber, "portador de arma" e "não portador". Eles descobriram que a sensibilidade do LIME melhorou quando vários pesos de saída para imagens individuais foram calculados e visualizados.

Os pesquisadores então compararam essas imagens médias com imagens individuais para avaliar a variabilidade e confiabilidade dos dois métodos LIME (ou seja, o método tradicional e o que eles propuseram). Eles descobriram que as técnicas tradicionais de LIME, sem os ajustes que eles fizeram, parecia ser instável devido à coloração binária simples que adotaram e à facilidade com que as regiões coloridas mudavam ao comparar análises diferentes. Lee e seus colegas também observaram que as regiões significativamente ponderadas das imagens eram consistentes, enquanto as regiões menos ponderadas mudaram de estado, devido à instabilidade inerente das técnicas de LIME.

A imagem destacada usando a informação média. Crédito:Lee et al.

"Técnicas como LIME mostram uma grande promessa de explicabilidade de IA, especialmente em um momento em que não há nada fácil, recursos de explicação prontamente disponíveis para sistemas de aprendizado de máquina, "Disse Lee." Embora a instabilidade percebida seja justificada, existem técnicas que podem ajudar a mitigar esse problema. Essas técnicas têm custos computacionais adicionais, por exemplo. executando a explicação várias vezes, o que significa que o usuário terá um atraso maior em gerar a explicação. "

O estudo conduzido por Lee e seus colegas oferece uma explicação valiosa de alguns dos fatores por trás da instabilidade do LIME, conforme observado em pesquisas anteriores. Suas descobertas sugerem que melhorar os métodos de ponderação para técnicas de explicabilidade pode aumentar sua estabilidade e levar a explicações mais confiáveis, em última análise, fomentando uma maior confiança na IA. Pesquisas futuras podem identificar técnicas numéricas mais avançadas para melhorar ainda mais a estabilidade do LIME e outros métodos de explicabilidade, reduzindo a sobrecarga adicional.

"Temos um interesse contínuo em sistemas de IA responsáveis que incluem explicações, mas também atenuam o preconceito e aumentam a robustez e a transparência, "Disse Lee." Melhorar a capacidade dos desenvolvedores de incorporar mais facilmente técnicas de explicabilidade em suas soluções de IA é um objetivo fundamental para nós. Recentemente, A IBM lançou um serviço de software que detecta automaticamente o preconceito e explica como a IA toma decisões. "

© 2019 Science X Network