Cynthia Rudin. Crédito:Duke University

À medida que a popularidade do chavão "aprendizado de máquina" continua crescendo, mais indústrias estão se voltando para algoritmos de computador para responder a perguntas importantes, incluindo campos de alto risco, como saúde, finanças e justiça criminal. Embora essa tendência possa levar a grandes melhorias nesses domínios, também pode levar a grandes problemas quando o algoritmo de aprendizado de máquina é uma chamada "caixa preta".

Uma caixa preta é um programa de aprendizado de máquina que não explica como chega às suas conclusões, ou porque é muito complicado para um ser humano entender ou porque seu funcionamento interno é proprietário. Em resposta às preocupações de que esses tipos de modelos podem incluir funcionamentos internos injustos - como o racismo - outra tendência crescente é criar modelos adicionais para "explicar" essas caixas pretas.

Em um novo editorial publicado em Nature Machine Intelligence , Cynthia Rudin, professor associado de ciência da computação, engenharia elétrica e informática, matemática, e ciência estatística na Duke University, argumenta que os modelos de caixa preta devem ser abandonados por decisões de alto risco. Mesmo quando os chamados modelos de explicação são criados, ela diz, os tomadores de decisão devem optar por modelos interpretáveis, que são completamente transparentes e facilmente compreendidos por seus usuários.

Modelos explicáveis estão errados

Modelos de aprendizado de máquina "explicáveis" são criados na tentativa de entender o que está acontecendo dentro de uma caixa preta. Se puder produzir os mesmos resultados, as pessoas presumem que é uma representação precisa.

Mas isso não.

Algoritmos explicáveis fornecem explicações que são imprecisas por definição - caso contrário, o complexo funcionamento interno da caixa preta seria desnecessário. Embora um modelo de explicação possa produzir resultados semelhantes ou mesmo exatos ao algoritmo de caixa preta original, não há como saber se ele está usando os mesmos parâmetros ou não.

"Se um décimo das explicações estiverem erradas, você não pode confiar nas explicações, e, portanto, você não pode confiar na caixa preta original, "diz Rudin." Se não podemos saber com certeza se nossa explicação está correta, não podemos saber se devemos confiar na explicação ou no modelo original. "

Mais não é igual a melhor

As pessoas costumam presumir que só porque um algoritmo de aprendizado de máquina é complicado, que é mais preciso do que um simples. Mas essa crença é infundada.

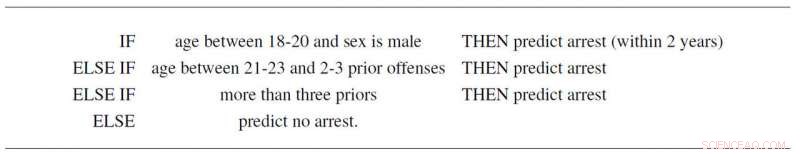

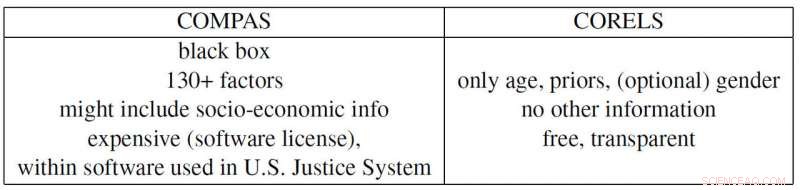

Por exemplo, Rudin e colaboradores Elaine Angelino, Margo Seltzer, Nicholas Larus-Stone e Daniel Alabi criaram um modelo interpretável simples para reincidência criminal com base apenas na idade, sexo e registro anterior. Não só segue três regras simples que qualquer pessoa pode entender, prevê a probabilidade de futuras prisões, assim como o polêmico programa "COMPAS", que é amplamente utilizado no Sistema de Justiça dos EUA. E além de ser uma caixa preta que muitos suspeitam empregar preconceitos racistas, O COMPAS usa mais de 130 informações para fazer suas previsões, o que é um grande problema por si só.

"Se as pessoas que inserem esses dados cometem um erro tipográfico apenas um por cento das vezes, então, mais de 1 em cada 2 pesquisas, em média, terá pelo menos um erro, "diz Rudin." Além disso, um modelo de caixa preta excessivamente complicado pode ter falhas sem que ninguém perceba, porque é difícil solucionar o problema. "

O exemplo da Propublica

A ProPublica acusou recentemente o algoritmo de caixa preta de reincidência do COMPAS de ser racialmente preconceituoso porque criou um modelo explicável baseado na raça que reproduz os resultados do COMPAS. Mas porque as pressões sociais criaram um sistema de justiça criminal onde o histórico criminal e a idade estão correlacionados com a raça em cada conjunto de dados, a caixa preta real do COMPAS pode, na verdade, depender apenas das duas primeiras variáveis. Mas, novamente, também poderia estar usando a raça como um fator, como afirma a ProPublica. O problema é que é impossível dizer porque o COMPAS é uma caixa preta proprietária (cara) que ninguém, exceto seus proprietários, pode examinar.

Rudin também aponta vários outros exemplos problemáticos contemporâneos. A caixa preta proprietária BreezoMeter disse aos usuários na Califórnia que a qualidade do ar era perfeitamente boa quando a qualidade do ar era perigosamente ruim de acordo com vários outros modelos. Um modelo de aprendizado de máquina projetado para leitura de raios-X estava pegando a palavra "portátil" dentro de uma imagem de raios-X, representando o tipo de equipamento de raio-X em vez do conteúdo médico da imagem, e, portanto, relatando conclusões ruins.

“Há um conflito de responsabilidade no uso de modelos de caixa preta para decisões de alto risco. As empresas que lucram com esses modelos não são necessariamente responsáveis pela qualidade das previsões individuais, "diz Rudin." Um prisioneiro cumprindo uma pena excessivamente longa devido a um erro inserido em uma pontuação de risco excessivamente complicada pode sofrer durante anos, enquanto a empresa que construiu este modelo lucra com sua complexidade e propriedade. Nesse sentido, os designers do modelo não são incentivados a ter cuidado em seu design, desempenho e facilidade de uso. Esses são alguns dos mesmos tipos de problemas que afetam as agências de classificação de crédito que precificaram as hipotecas em 2008. "

"Espero que as pessoas percebam os riscos dos modelos explicáveis e que na verdade não precisem de caixas pretas. Eles podem usar modelos totalmente interpretáveis, "diz Rudin." Eu gostaria de ver um sistema no qual nenhum algoritmo de caixa preta fosse usado para uma decisão de alto risco, a menos que não houvesse um modelo interpretável igualmente preciso. Eu trabalhei em muitas aplicações diferentes - assistência médica, energia, risco de crédito, reincidência criminal, visão computacional - e eu nunca encontrei um aplicativo em que uma caixa preta seja realmente necessária. "