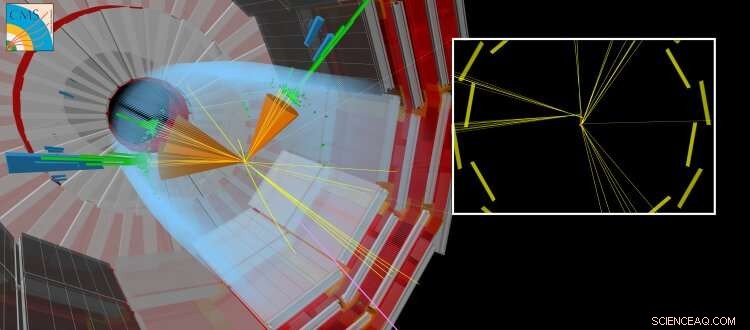

Uma colisão CMS simulada onde uma partícula de vida longa é produzida junto com outros jatos 'regulares'. A partícula de vida longa viaja por uma curta distância antes de decair, criando partículas que parecem deslocadas do ponto onde os feixes do LHC colidiram. Crédito:CERN

Hoje em dia, as redes neurais artificiais têm impacto em muitas áreas de nossa vida cotidiana. Eles são usados para uma ampla variedade de tarefas complexas, como dirigir carros, realizando reconhecimento de fala (por exemplo, Siri, Cortana, Alexa), sugerindo itens e tendências de compras, ou melhorar os efeitos visuais em filmes (por exemplo, personagens animados como Thanos do filme Guerra infinita pela Marvel).

Tradicionalmente, algoritmos são feitos à mão para resolver tarefas complexas. Isso requer que os especialistas despendam uma quantidade significativa de tempo para identificar as estratégias ideais para várias situações. Redes neurais artificiais - inspiradas por neurônios interconectados no cérebro - podem aprender automaticamente a partir dos dados uma solução quase ótima para um determinado objetivo. Muitas vezes, o aprendizado automatizado ou "treinamento" necessário para a obtenção dessas soluções é "supervisionado" por meio de informações complementares fornecidas por especialista. Outras abordagens são "não supervisionadas" e podem identificar padrões nos dados. A teoria matemática por trás das redes neurais artificiais evoluiu ao longo de várias décadas, no entanto, apenas recentemente desenvolvemos nossa compreensão de como treiná-los com eficiência. Os cálculos necessários são muito semelhantes aos executados por placas gráficas de vídeo padrão (que contêm uma unidade de processamento gráfico ou GPU) ao renderizar cenas tridimensionais em videogames. A capacidade de treinar redes neurais artificiais em um período de tempo relativamente curto é possível explorando os recursos de computação paralela maciça de GPUs de uso geral. A florescente indústria de videogames impulsionou o desenvolvimento de GPUs. Este avanço, junto com o progresso significativo na teoria do aprendizado de máquina e o volume cada vez maior de informações digitalizadas, ajudou a inaugurar a era da inteligência artificial e do "aprendizado profundo".

No campo da física de alta energia, o uso de técnicas de aprendizado de máquina, como redes neurais simples ou árvores de decisão, estão em uso há várias décadas. Mais recentemente, a teoria e as comunidades experimentais estão cada vez mais se voltando para as técnicas de ponta, como arquiteturas de rede neural "profundas", para nos ajudar a entender a natureza fundamental do nosso Universo. O modelo padrão da física de partículas é uma coleção coerente de leis físicas - expressas na linguagem da matemática - que governam as partículas e forças fundamentais, que por sua vez explica a natureza do nosso Universo visível. No CERN LHC, muitos resultados científicos se concentram na busca por novas partículas "exóticas" que não são previstas pelo modelo padrão. Essas partículas hipotéticas são as manifestações de novas teorias que visam responder a questões como:por que o Universo é predominantemente composto de matéria em vez de antimatéria, ou qual é a natureza da matéria escura?

Figura 1:Esquema da arquitetura da rede. As seções superiores (laranja e azul) do diagrama ilustram os componentes da rede que são usados para distinguir jatos produzidos nos decaimentos de partículas de vida longa de jatos produzidos por outros meios, treinado com dados simulados. A parte inferior (verde) do diagrama mostra os componentes que são treinados usando dados reais de colisão. Crédito:CERN

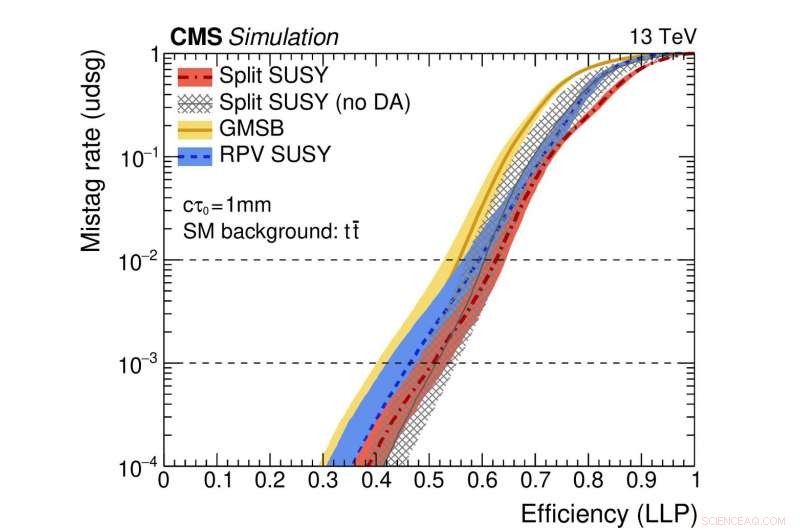

Figura 2:Uma ilustração do desempenho da rede. As curvas coloridas representam o desempenho de diferentes modelos supersimétricos teóricos. O eixo horizontal dá a eficiência para identificar corretamente um decaimento de partícula de vida longa (ou seja, a taxa de verdadeiro positivo). O eixo vertical mostra a taxa de falsos positivos correspondente, que é a fração de jatos padrão identificados erroneamente como originários da decadência de uma partícula de vida longa. Como um exemplo, usamos um ponto da curva vermelha onde a fração de partículas genuínas de vida longa que são corretamente identificadas é 0,5 (ou seja, 50%). Este método identifica erroneamente apenas um jato regular em cada mil como originado de um decaimento de partículas de longa duração. Crédito:CERN

Recentemente, as pesquisas por novas partículas que existem por mais de um momento fugaz no tempo antes de se decomporem em partículas comuns têm recebido atenção especial. Essas partículas de "vida longa" podem viajar distâncias mensuráveis (frações de milímetros ou mais) do ponto de colisão próton-próton em cada experimento do LHC antes de decair. Muitas vezes, as previsões teóricas assumem que a partícula de vida longa é indetectável. Nesse caso, apenas as partículas da decadência da partícula não descoberta deixarão rastros nos sistemas de detecção, levando à assinatura experimental atípica de partículas aparentemente aparecendo do nada e deslocadas do ponto de colisão.

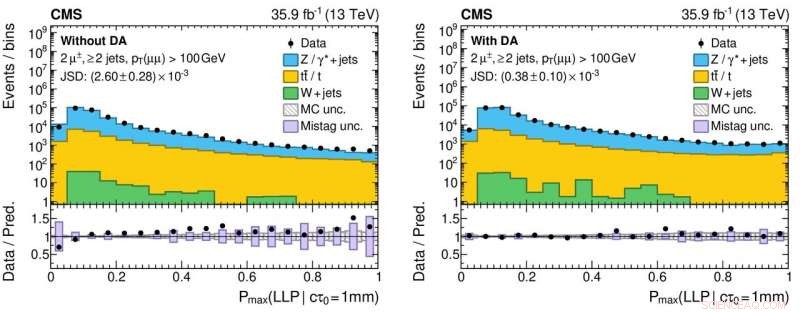

Um aspecto novo deste estudo envolve o uso de dados de eventos reais de colisão, bem como eventos simulados, para treinar a rede. Essa abordagem é usada porque a simulação - embora muito sofisticada - não reproduz exaustivamente todos os detalhes dos dados reais da colisão. Em particular, os jatos que surgem de decaimentos de partículas de longa vida são desafiadores para simular com precisão. O efeito da aplicação desta técnica, apelidado de "adaptação de domínio, "é que as informações fornecidas pela rede neural concordam com um alto nível de precisão para dados de colisão reais e simulados. Esse comportamento é uma característica crucial para algoritmos que serão usados por pesquisas de processos raros de nova física, pois os algoritmos devem demonstrar robustez e confiabilidade quando aplicados aos dados.

Figura 3:Histogramas dos valores de saída da rede neural para dados reais (marcadores circulares pretos) e simulados (histogramas coloridos) de colisão próton-próton sem (painel esquerdo) e com (painel direito) a aplicação de adaptação de domínio. Os painéis inferiores exibem as relações entre os números de dados reais e eventos simulados obtidos de cada compartimento do histograma. As proporções são significativamente mais próximas da unidade para o painel direito, o que indica uma melhor compreensão do desempenho da rede neural para dados de colisão real, o que é crucial para reduzir resultados científicos falsos positivos (e falsos negativos!) na busca por novas partículas exóticas. Crédito:CERN

O CMS Collaboration implantará esta nova ferramenta como parte de sua busca contínua por produtos exóticos, partículas de vida longa. Este estudo é parte de um estudo mais amplo, esforço coordenado em todos os experimentos do LHC para usar técnicas de máquina modernas para melhorar como as grandes amostras de dados são registradas pelos detectores e a análise de dados subsequente. Por exemplo, o uso de adaptação de domínio pode facilitar a implantação de modelos robustos aprendidos por máquina como parte de resultados futuros. A experiência adquirida com esses tipos de estudo aumentará o potencial da física durante a corrida 3, de 2021, e além com o LHC de alta luminosidade.