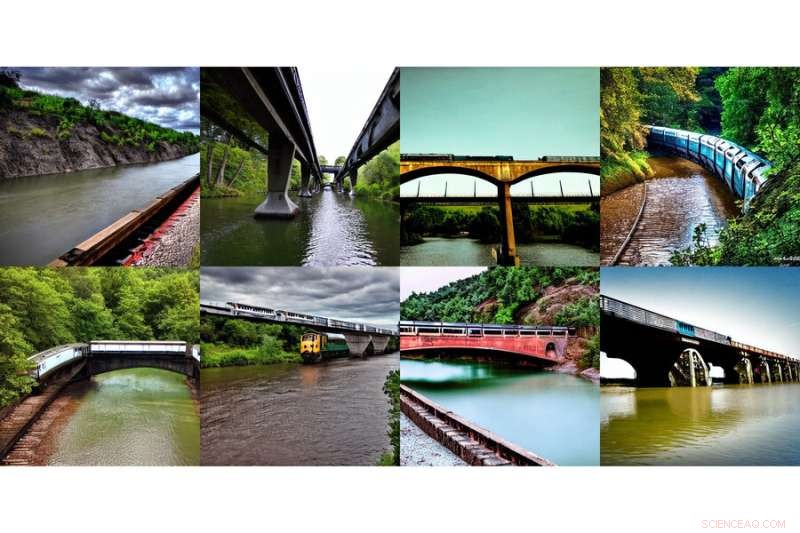

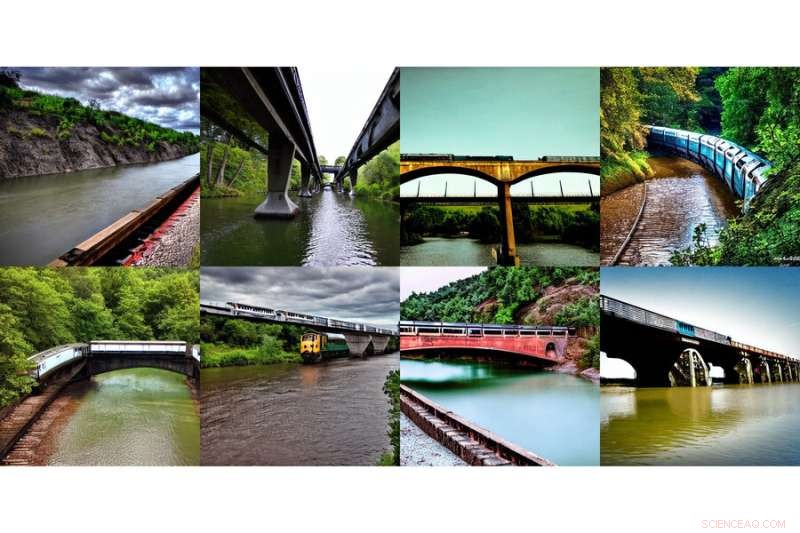

Esta matriz de imagens geradas, mostrando "um trem em uma ponte" e "um rio sob a ponte", foi gerada usando um novo método desenvolvido por pesquisadores do MIT. Crédito:Massachusetts Institute of Technology

A internet teve um momento de bem-estar coletivo com a introdução do DALL-E, um gerador de imagens baseado em inteligência artificial inspirado no artista Salvador Dali e no adorável robô WALL-E que usa linguagem natural para produzir qualquer imagem misteriosa e bonita que seu coração desejar . Ver entradas digitadas como "Gopher sorridente segurando uma casquinha de sorvete" instantaneamente ganhando vida claramente ressoou com o mundo.

Dizer gopher sorridente e atributos para aparecer na tela não é uma tarefa pequena. DALL-E 2 usa algo chamado modelo de difusão, onde tenta codificar todo o texto em uma descrição para gerar uma imagem. Mas uma vez que o texto tem muito mais detalhes, é difícil para uma única descrição capturar tudo. Além disso, embora sejam altamente flexíveis, às vezes eles lutam para entender a composição de certos conceitos, como confundir os atributos ou relações entre diferentes objetos.

Para gerar imagens mais complexas e com melhor compreensão, cientistas do Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL) do MIT estruturaram o modelo típico de um ângulo diferente:eles adicionaram uma série de modelos juntos, onde todos cooperam para gerar as imagens desejadas capturando vários aspectos diferentes conforme solicitado pelo texto ou rótulos de entrada. Para criar uma imagem com dois componentes, digamos, descritos por duas frases de descrição, cada modelo abordaria um componente específico da imagem.

Essa série de imagens geradas, mostrando “um rio que leva às montanhas” e “árvores vermelhas ao lado”, foi gerada usando um novo método desenvolvido por pesquisadores do MIT. Crédito:Instituto de Tecnologia de Massachusetts

Os modelos aparentemente mágicos por trás da geração de imagens funcionam sugerindo uma série de etapas de refinamento iterativo para chegar à imagem desejada. Começa com uma imagem "ruim" e depois a refina gradualmente até se tornar a imagem selecionada. Ao compor vários modelos juntos, eles refinam conjuntamente a aparência em cada etapa, de modo que o resultado é uma imagem que exibe todos os atributos de cada modelo. Ao ter vários modelos cooperando, você pode obter combinações muito mais criativas nas imagens geradas.

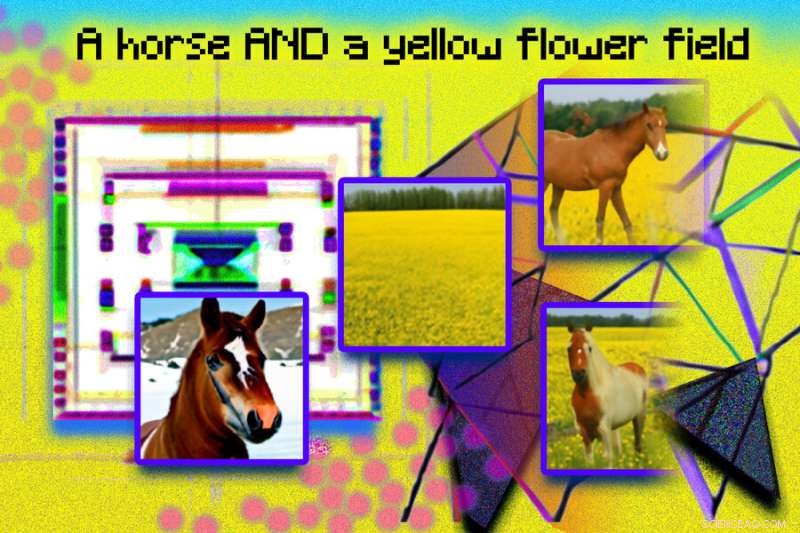

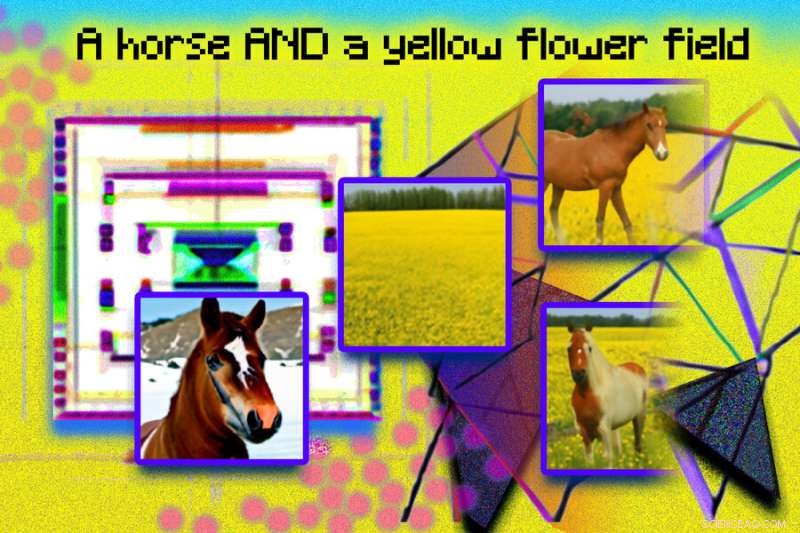

Tomemos, por exemplo, um caminhão vermelho e uma casa verde. O modelo vai confundir os conceitos de caminhão vermelho e casa verde quando essas frases ficarem muito complicadas. Um gerador típico como o DALL-E 2 pode fazer um caminhão verde e uma casa vermelha, então ele troca essas cores. A abordagem da equipe pode lidar com esse tipo de vinculação de atributos com objetos e, especialmente quando há vários conjuntos de coisas, pode lidar com cada objeto com mais precisão.

"O modelo pode efetivamente modelar posições de objetos e descrições relacionais, o que é um desafio para os modelos de geração de imagens existentes. Por exemplo, coloque um objeto e um cubo em uma determinada posição e uma esfera em outra. DALL-E 2 é bom em gerar imagens, mas às vezes tem dificuldade em entender as relações de objeto", diz MIT CSAIL Ph.D. Shuang Li, estudante e coautor principal, "Além da arte e da criatividade, talvez pudéssemos usar nosso modelo para ensinar. Se você quiser dizer a uma criança para colocar um cubo no topo de uma esfera, e se dissermos isso em linguagem, é pode ser difícil para eles entenderem. Mas nosso modelo pode gerar a imagem e mostrá-los."

Os pesquisadores conseguiram criar algumas imagens surpreendentes e surreais com o texto “um cachorro” e “o céu”. À esquerda aparecem um cachorro e nuvens separadamente, rotulados como “cachorro” e “céu” embaixo, e à direita aparecem duas imagens de cães parecidos com nuvens com o rótulo “cachorro E céu” embaixo. Crédito:Instituto de Tecnologia de Massachusetts

Deixando Dali orgulhoso Composable Diffusion - o modelo da equipe - usa modelos de difusão junto com operadores de composição para combinar descrições de texto sem treinamento adicional. A abordagem da equipe captura detalhes do texto com mais precisão do que o modelo de difusão original, que codifica diretamente as palavras como uma única frase longa. Por exemplo, dado "um céu rosa" E "uma montanha azul no horizonte" E "flores de cerejeira na frente da montanha", o modelo da equipe conseguiu produzir essa imagem exatamente, enquanto o modelo de difusão original tornou o céu azul e tudo na frente das montanhas rosa.

"O fato de nosso modelo ser componível significa que você pode aprender diferentes partes do modelo, uma de cada vez. Você pode primeiro aprender um objeto em cima do outro, depois aprender um objeto à direita do outro e depois aprender algo à esquerda de outro", diz o co-autor principal e MIT CSAIL Ph.D. estudante Yilun Du. "Como podemos compor isso juntos, você pode imaginar que nosso sistema nos permite aprender de forma incremental a linguagem, as relações ou o conhecimento, o que achamos ser uma direção bastante interessante para trabalhos futuros".

Esta ilustração fotográfica foi criada usando imagens geradas a partir de um sistema do MIT chamado Composable Diffusion, e organizadas no Photoshop. Frases como “modelo de difusão” e “rede” foram usadas para gerar os pontos rosa e imagens geométricas e angulares. A frase “um cavalo E um campo de flores amarelas” está incluída na parte superior da imagem. As imagens geradas de um cavalo e um campo amarelo aparecem à esquerda, e as imagens combinadas de um cavalo em um campo de flores amarelas aparecem à direita. Crédito:Instituto de Tecnologia de Massachusetts

Embora tenha mostrado proeza na geração de imagens fotorrealistas complexas, ainda enfrentou desafios, pois o modelo foi treinado em um conjunto de dados muito menor do que aqueles como o DALL-E 2, então havia alguns objetos que ele simplesmente não conseguia capturar.

Agora que a Composable Diffusion pode trabalhar em cima de modelos generativos, como o DALL-E 2, os cientistas querem explorar o aprendizado contínuo como um possível próximo passo. Dado que geralmente mais é adicionado às relações de objeto, eles querem ver se os modelos de difusão podem começar a "aprender" sem esquecer o conhecimento previamente aprendido - para um lugar onde o modelo possa produzir imagens com o conhecimento anterior e o novo.

"Esta pesquisa propõe um novo método para compor conceitos na geração de texto para imagem não concatenando-os para formar um prompt, mas calculando pontuações em relação a cada conceito e compondo-os usando operadores de conjunção e negação", diz Mark Chen, co-criador do DALL-E 2 e cientista pesquisador da OpenAI. "Esta é uma boa ideia que aproveita a interpretação baseada em energia de modelos de difusão para que velhas ideias sobre composicionalidade usando modelos baseados em energia possam ser aplicadas. A abordagem também é capaz de fazer uso de orientação livre de classificador, e é surpreendente veja que ele supera a linha de base GLIDE em vários benchmarks de composição e pode produzir qualitativamente tipos muito diferentes de gerações de imagem."

"Os seres humanos podem compor cenas incluindo diferentes elementos de várias maneiras, mas essa tarefa é desafiadora para os computadores", diz Bryan Russel, pesquisador da Adobe Systems. "Este trabalho propõe uma formulação elegante que compõe explicitamente um conjunto de modelos de difusão para gerar uma imagem a partir de um prompt complexo de linguagem natural."

+ Explorar mais Revolucionando a geração de imagens por meio da IA:transformando texto em imagens

Esta história foi republicada como cortesia do MIT News (web.mit.edu/newsoffice/), um site popular que cobre notícias sobre pesquisa, inovação e ensino do MIT.