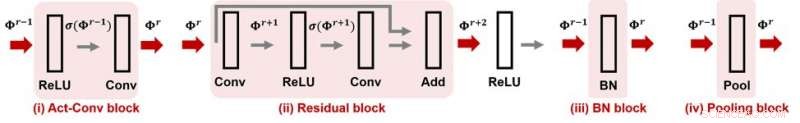

Figura 1. CNN-Cert oferece suporte a muitos módulos populares e operações de camada em redes neurais convolucionais. Crédito:IBM

Ao comprar um relógio, você pode notar sua classificação de resistência à água, o que indica que o relógio tem garantia de ser à prova d'água até certo nível. E quanto à sua rede neural? Pode-se garantir que uma rede neural seja "à prova de ataque", o que significa que sua funcionalidade é robusta contra perturbações adversas? Se então, como isso pode ser quantificado com um número de resistência ao ataque? Na AAAI 2019, nosso grupo de pesquisadores do MIT e IBM Research propõe um método eficiente e eficaz para certificar a resistência a ataques de redes neurais convolucionais a dados de entrada fornecidos. Este artigo foi selecionado para apresentação oral na AAAI 2019 (30 de janeiro de 14h00-3h30 @ coral 1).

Os modelos atuais de redes neurais profundas são conhecidos por serem vulneráveis a perturbações adversas. Uma perturbação cuidadosamente elaborada, embora pequena, nos dados de entrada poderia facilmente manipular a previsão da saída do modelo, incluindo tarefas de aprendizado de máquina, como reconhecimento de objetos, tradução de fala, legendagem de imagens, e classificação de texto, para nomear alguns. A falta de robustez para perturbações adversárias incorre em novos desafios na pesquisa de IA e pode impedir nossa confiança nos sistemas de IA.

Dada uma rede neural e considerando um modelo de ameaça adversária em que a força de ataque é caracterizada pela norma Lp da perturbação, para qualquer entrada de dados, sua robustez adversária pode ser quantificada como a força de ataque mínima necessária para alterar a previsão do modelo (consulte a Figura 1 no post anterior para obter uma ilustração visual). Aqui, um certificado de robustez à prova de ataque para uma entrada especifica uma força de ataque ε e oferece a seguinte resistência garantida a ataques:sob o modelo de ameaça limitada por norma, nenhuma perturbação adversária pode alterar a previsão da entrada se sua força de ataque for menor que ε. Em outras palavras, ε maior significa que a entrada é mais robusta. Esta certificação de robustez pode ser crucial em aplicações de IA de segurança crítica ou com custo reduzido que requerem alta precisão e confiabilidade, como sistemas de direção autônomos.

Nosso método proposto, CNN-Cert, fornece uma estrutura geral e eficiente para certificar o nível de robustez adversarial de redes neurais convolucionais para dados de entrada dados. Nossa estrutura é geral:podemos lidar com várias arquiteturas, incluindo camadas convolucionais, camadas de pooling máximo, camada de normalização em lote, blocos residuais, bem como funções gerais de ativação, como ReLU, tanh, sigmóide e arctan. A Figura 1 mostra alguns blocos de construção comumente usados considerados em nossa estrutura CNN-Cert. A principal técnica no CNN-Cert é derivar a saída de rede explícita, considerando as relações de entrada / saída de cada bloco de construção, marcados como setas vermelhas. A camada de ativação pode ser ativações gerais diferentes de ReLU. Nossa abordagem também é eficiente - explorando a estrutura especial das camadas convolucionais, alcançamos até 17 e 11 vezes de aceleração em comparação com os algoritmos de certificação de última geração e 366 vezes de aceleração em comparação com uma abordagem padrão dual-LP, enquanto nosso método obtém limites de resistência a ataques semelhantes ou até melhores .

Esta história foi republicada por cortesia da IBM Research. Leia a história original aqui.