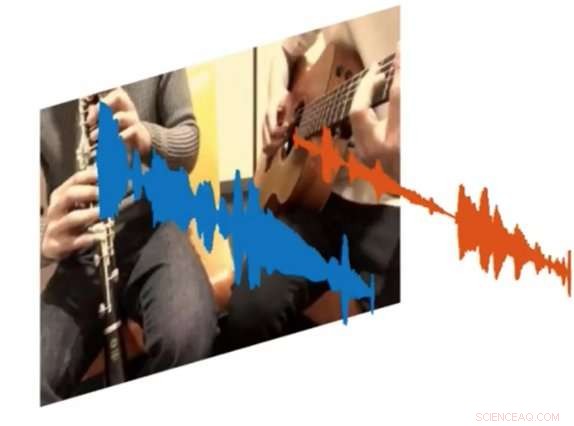

p Um novo sistema de IA chamado PixelPlayer pode olhar para uma imagem e determinar qual conjunto de pixels é responsável por fazer conjuntos específicos de ondas sonoras. Crédito:MIT CSAIL

p Um novo sistema de IA chamado PixelPlayer pode olhar para uma imagem e determinar qual conjunto de pixels é responsável por fazer conjuntos específicos de ondas sonoras. Crédito:MIT CSAIL

p Músicos amadores e profissionais podem passar horas lendo clipes do YouTube para descobrir exatamente como tocar certas partes de suas músicas favoritas. Mas e se houvesse uma maneira de reproduzir um vídeo e isolar o único instrumento que você queria ouvir? p Esse é o resultado de um novo projeto de IA do Laboratório de Ciência da Computação e Inteligência Artificial do MIT (CSAIL):um sistema de aprendizado profundo que pode assistir a um vídeo de uma apresentação musical, e isolar os sons de instrumentos específicos e torná-los mais altos ou mais suaves.

p O sistema, que é "auto-supervisionado, "não requer nenhuma anotação humana sobre o que os instrumentos são ou como eles soam.

p Treinado em mais de 60 horas de vídeos, o sistema "PixelPlayer" pode ver uma performance musical nunca antes vista, identificar instrumentos específicos em nível de pixel, e extraia os sons associados a esses instrumentos.

p Por exemplo, pode fazer o vídeo de uma tuba e um trompete tocando a música tema de "Super Mario Brothers", e separar as ondas sonoras associadas a cada instrumento.

p Os pesquisadores dizem que a capacidade de alterar o volume de instrumentos individuais significa que, no futuro, sistemas como esse podem ajudar os engenheiros a melhorar a qualidade de áudio de filmagens de shows antigos. Você pode até imaginar produtores pegando partes de instrumentos específicos e prevendo como eles soariam com outros instrumentos (ou seja, uma guitarra elétrica trocada por uma acústica).

p Em um novo jornal, a equipe demonstrou que o PixelPlayer pode identificar os sons de mais de 20 instrumentos comumente vistos. O autor principal Hang Zhao diz que o sistema seria capaz de identificar muitos mais instrumentos se tivesse mais dados de treinamento, embora ainda possa ter problemas para lidar com diferenças sutis entre subclasses de instrumentos (como um sax alto versus um tenor).

p Esforços anteriores para separar as fontes de som concentraram-se exclusivamente no áudio, que freqüentemente requer extensa rotulagem humana. Em contraste, PixelPlayer apresenta o elemento de visão, que, segundo os pesquisadores, torna desnecessários os rótulos humanos, visto que a visão fornece auto-supervisão.

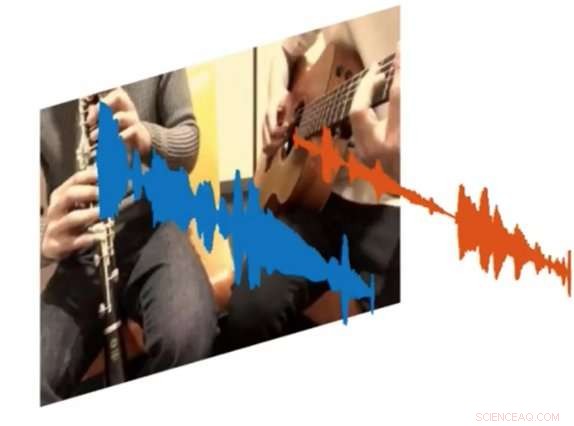

p O sistema primeiro localiza as regiões da imagem que produzem sons, e então separa os sons de entrada em um conjunto de componentes que representam o som de cada pixel.

p "Esperávamos um cenário ideal em que pudéssemos reconhecer quais instrumentos fazem quais tipos de sons, "diz Zhao, um Ph.D. estudante do CSAIL. "Ficamos surpresos por podermos localizar espacialmente os instrumentos no nível do pixel. Ser capaz de fazer isso abre muitas possibilidades, como ser capaz de editar o áudio de instrumentos individuais com um único clique no vídeo. "

p PixelPlayer usa métodos de "aprendizado profundo, "o que significa que ele encontra padrões em dados usando as chamadas" redes neurais "que foram treinadas em vídeos existentes. Especificamente, uma rede neural analisa as imagens do vídeo, um analisa o áudio, e um terceiro "sintetizador" associa pixels específicos com ondas sonoras específicas para separar os diferentes sons.

p PixelPlayer também inclui uma interface que permite aos usuários alterar o volume de instrumentos específicos na mixagem. Crédito:MIT CSAIL

p PixelPlayer também inclui uma interface que permite aos usuários alterar o volume de instrumentos específicos na mixagem. Crédito:MIT CSAIL

p O fato de o PixelPlayer usar o chamado aprendizado profundo "auto-supervisionado" significa que a equipe do MIT não entende explicitamente todos os aspectos de como aprende quais instrumentos fazem quais sons.

p Contudo, Zhao diz que ele pode dizer que o sistema parece reconhecer elementos reais da música. Por exemplo, certas frequências harmônicas parecem se correlacionar com instrumentos como o violino, enquanto os padrões de pulso rápido correspondem a instrumentos como o xilofone.

p Zhao diz que um sistema como o PixelPlayer poderia até ser usado em robôs para entender melhor os sons ambientais que outros objetos fazem, como animais ou veículos. p

Esta história foi republicada por cortesia do MIT News (web.mit.edu/newsoffice/), um site popular que cobre notícias sobre pesquisas do MIT, inovação e ensino.